-

可解释性机器学习task01-预备知识

-

-

-

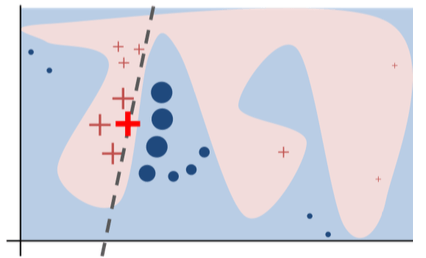

现代机器学习是统计机器学习尤其是深度学习,使用数据拟合数据分布和决策边间,有着高维非凸,决策时是一个黑箱

-

一些灵魂之问

-

AI的脑回路是怎样的? Al如何做出决策?是否符合人类的直觉和常识?

-

AI会重点关注哪些特征,这些特征是不是真的有用?

-

如何衡量不同特征对Al预测结果的不同贡献?

-

AI什么时候work,什么时候不work ?

-

AI有没有过拟合?泛化能力如何?

-

会不会被黑客误导,让AI指鹿为马?

-

如果样本的某个特征变大,会对Al预测结果产生什么影响?

-

如果Al误判,为什么会犯错?如何能不犯错?

-

两个Al预测结果不同,该信哪一个?

-

能让Al把学到的特征教给人类吗?

-

AI在AIGC领域任然会存在着一些问题

-

说明其并没有正真学到这部分的知识

-

一个黑箱,容易犯错

-

在一些关键邻域比如自动驾驶领域,如何让人类相信黑箱算法

-

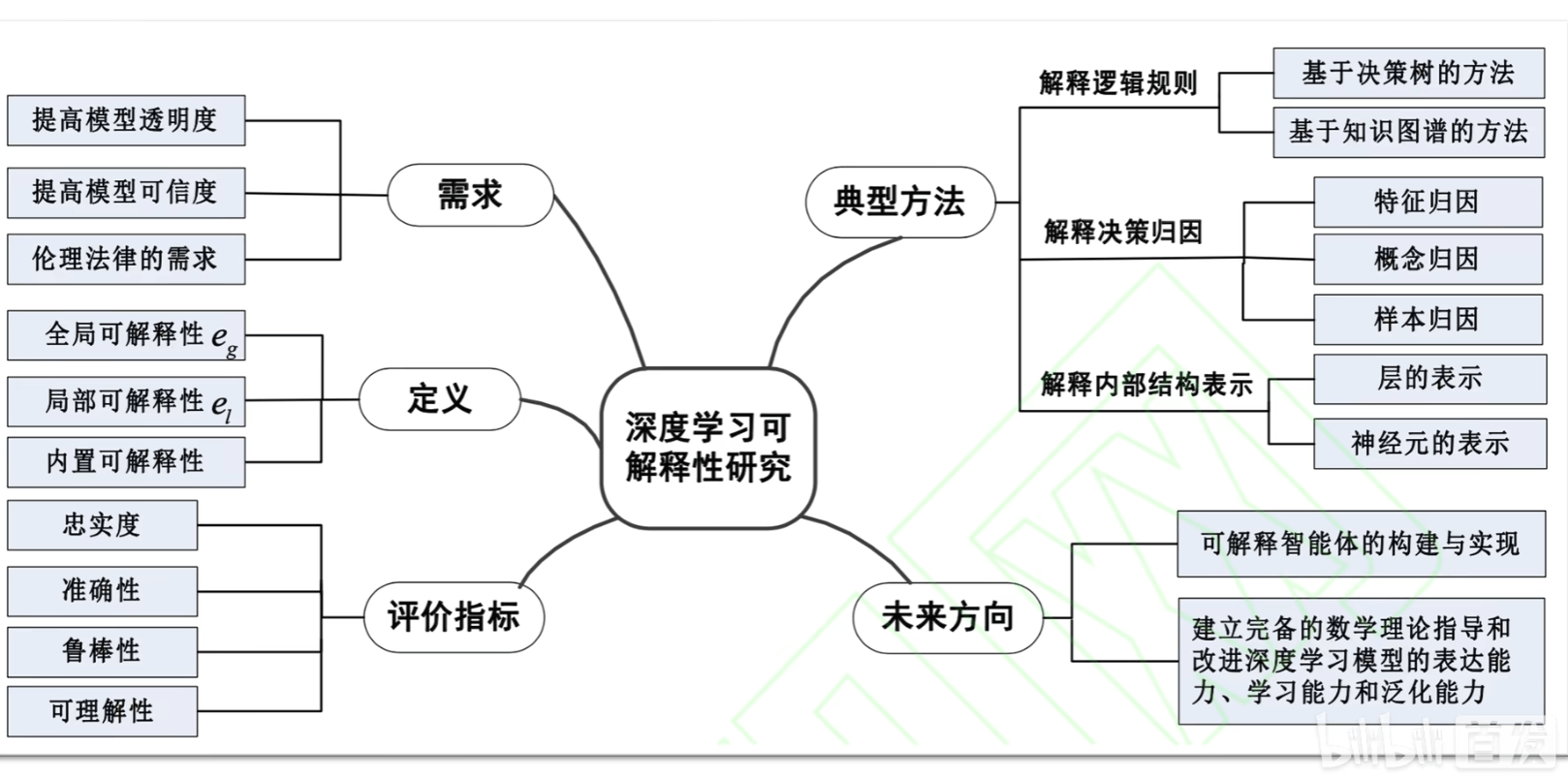

可解释学习就是打开黑箱学习的研究

同济子豪兄选题建议

-

可解释性学习可以和AI的各个方向进行交叉

-

data mining,NLP,RL,KG,联邦学习

-

CV

-

NLP

-

推荐系统

-

通用的研究方法

-

具体的task的结合

-

大模型、弱监督、缺陷异常检测、细粒度分类、决策

AI和强化学习、图神经网络、

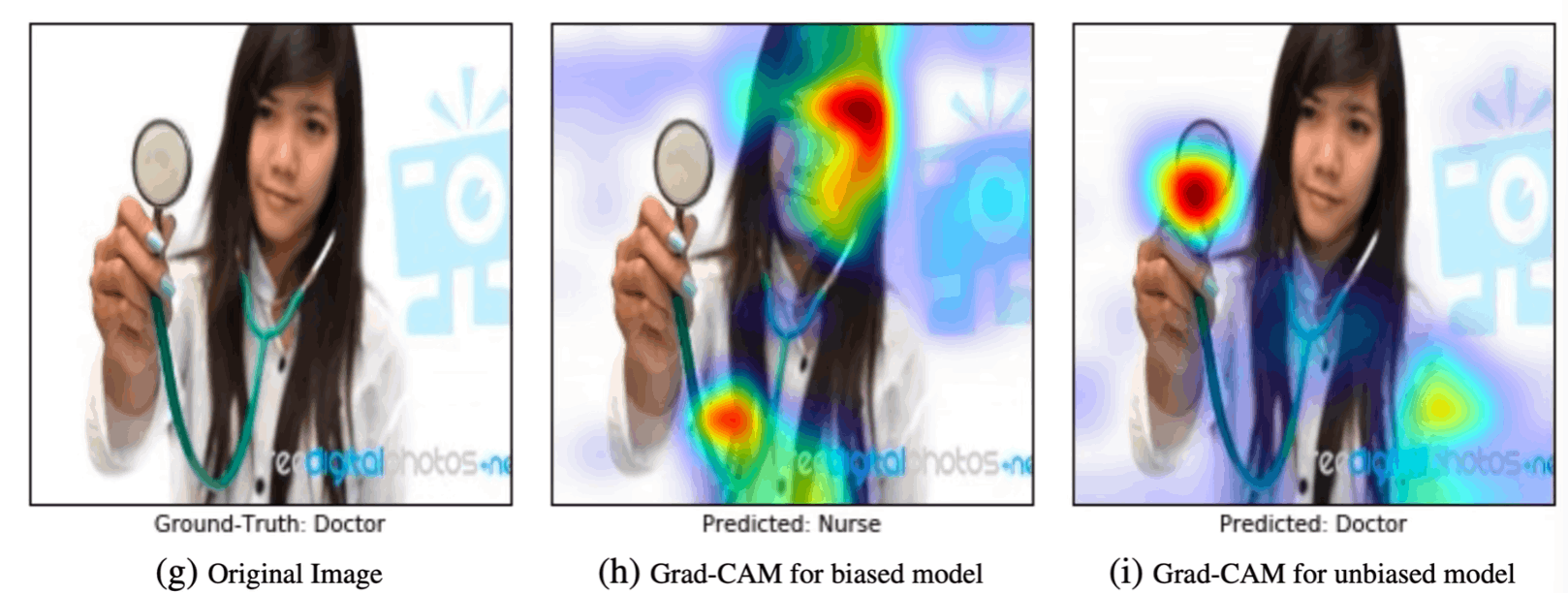

Al纠偏

、Al4Science、 Machine

Teaching、对抗样本、可信计算、联邦学习。

-

写paper可以结合某个可解释的算法分析细分领域的任务

-

[ 基于声成像与卷积神经网络的轴承故障诊断方法及其可解释性研究](https://kns.cnki.net/kns8/Detail?sfield=fn&QueryID=10&CurRec=4&DbCode= CJFD&dbname=CJFDLAST2022&filename=ZDCJ202216029&urlid=&yx=)

-

[雷达图像深度学习模型的可解释性研究与探索](https://kns.cnki.net/kns8/Detail?sfield=fn&QueryID=10&CurRec=7&DbCode= CAPJ&dbname=CAPJLAST&filename=PZKX20220613003&urlid=11.5846.TP.20220613.0913.008&yx=Y)

-

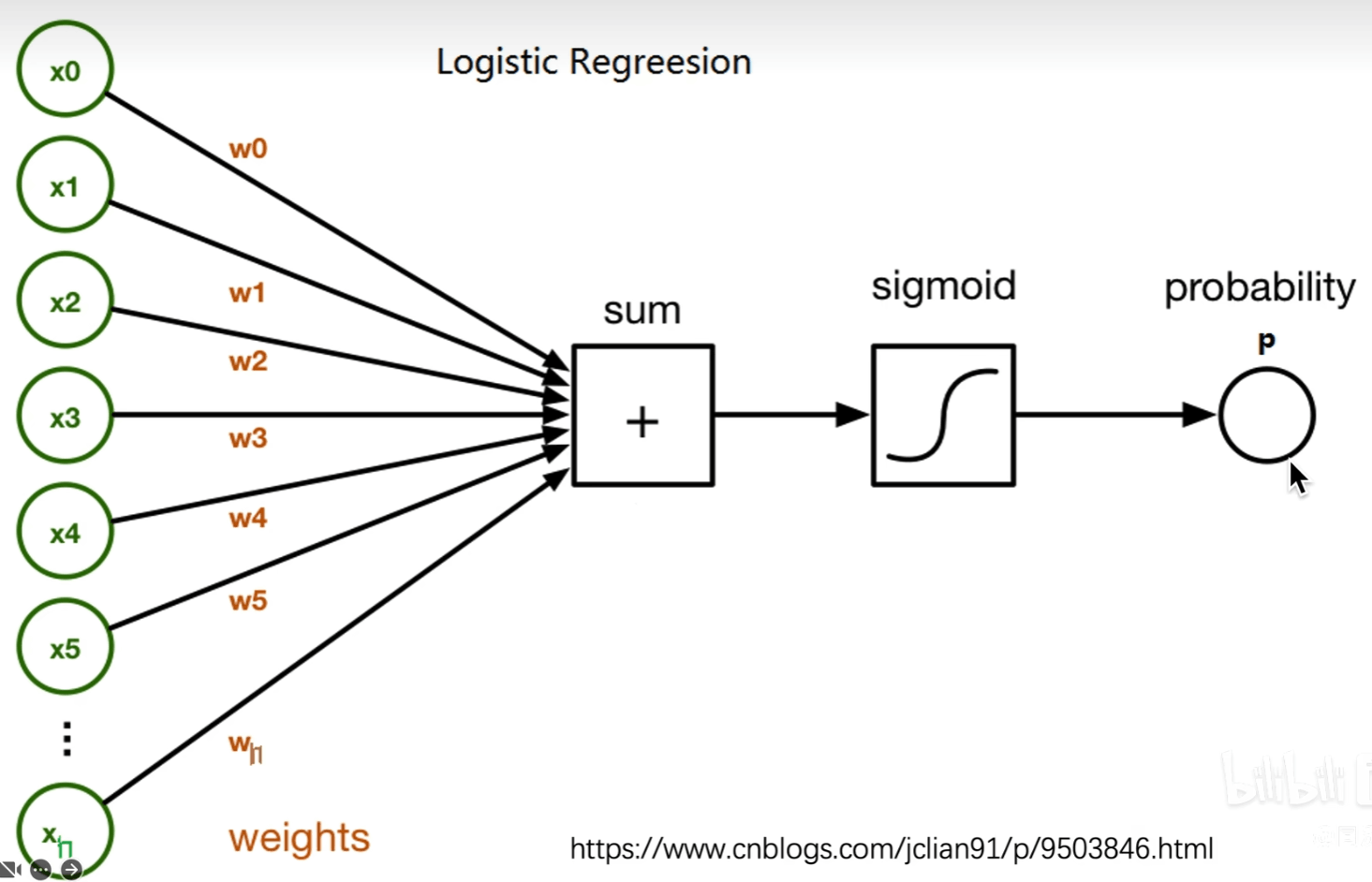

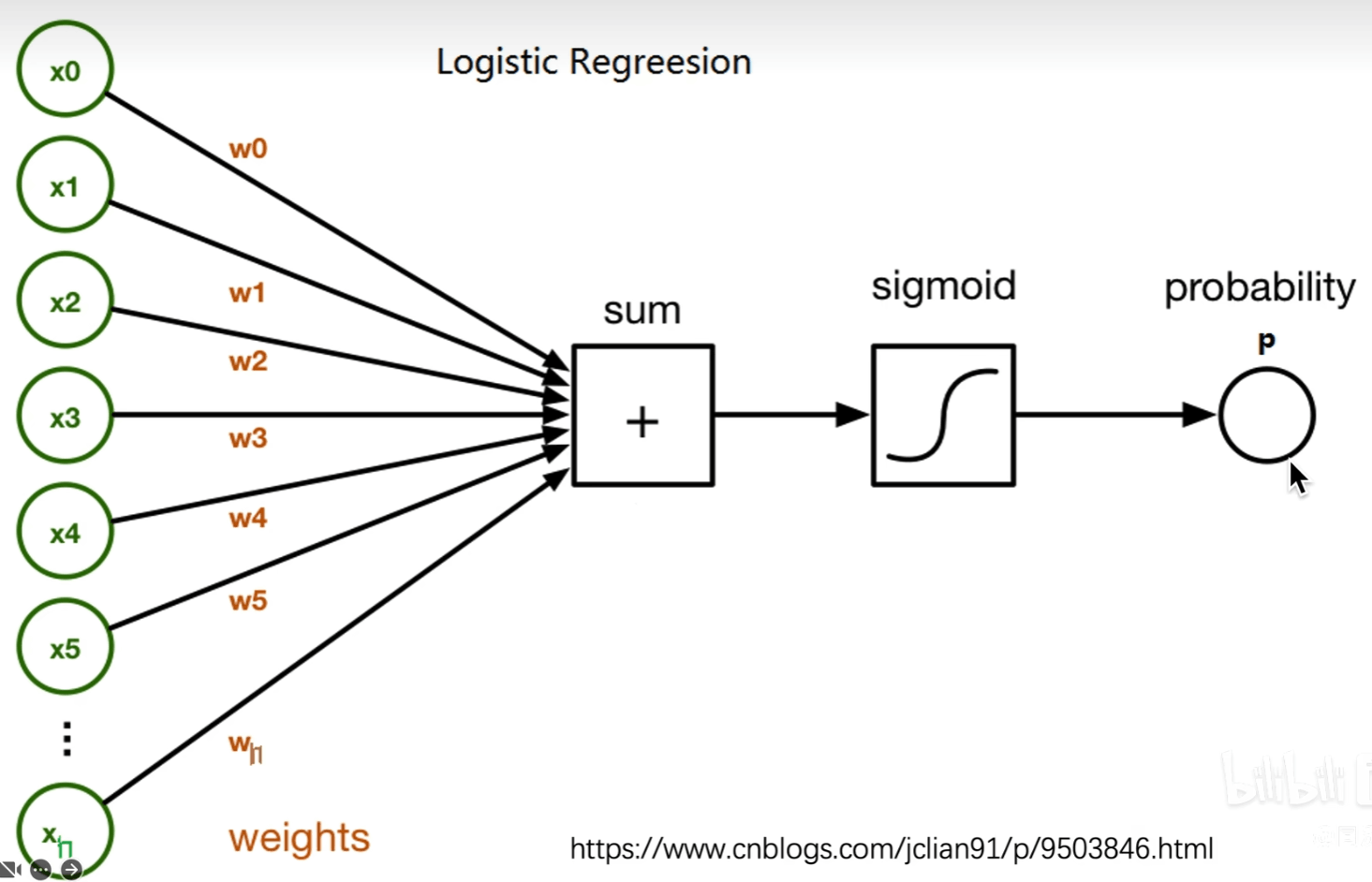

输入特征可以理解,权重直观反映了那个特征的决策重要性

-

-

线性回归

-

决策树

-

朴素贝叶斯

-

可视化卷积核/特征图

-

ZF Net

-

介绍了一种新的可视化技术,可以深入了解中间特征层的功能和分类器的操作

-

通过

遮挡、缩放、平移、旋转

的间接方法对预测的影响来理解CNN

-

利用

反卷积

找到使得某个神经元激活的pixel或小图

-

RCNN

-

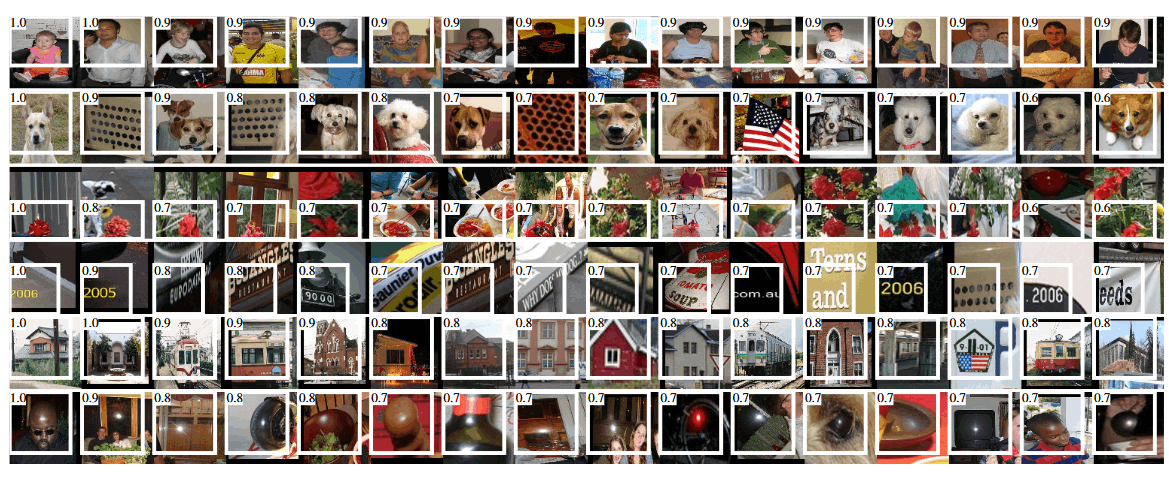

从神经元激活找原始小图

-

原文figure3,实验3.1

-

作者从第五层pooling的神经元进行了可视化,白框是感受野以及激活值

-

可以看到,有一些神经元捕捉到了特定的概念,比如第一行的人,第四行的字

-

有些神经元捕捉纹理和材质

-

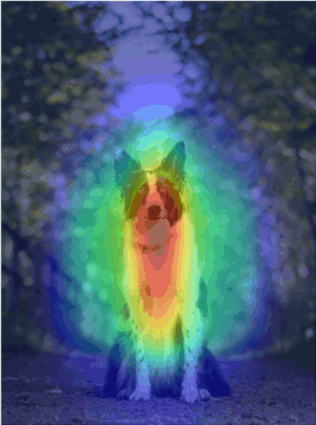

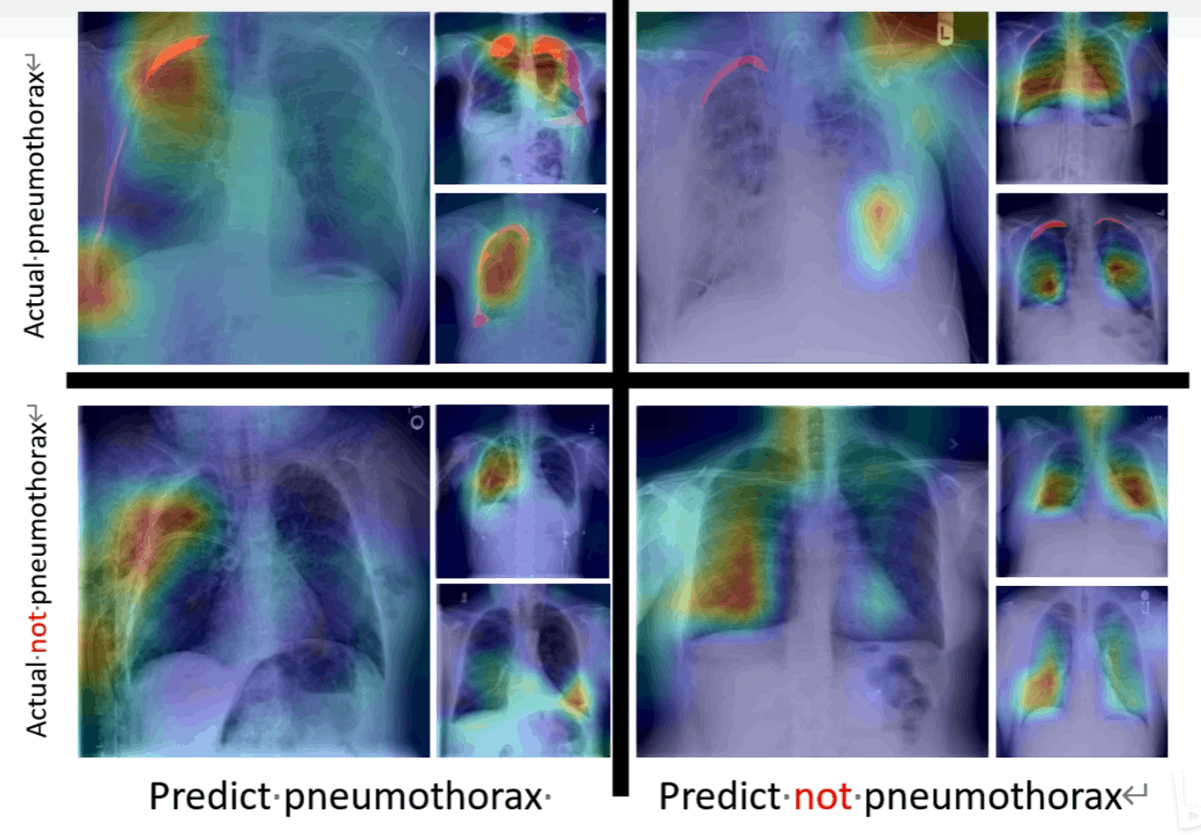

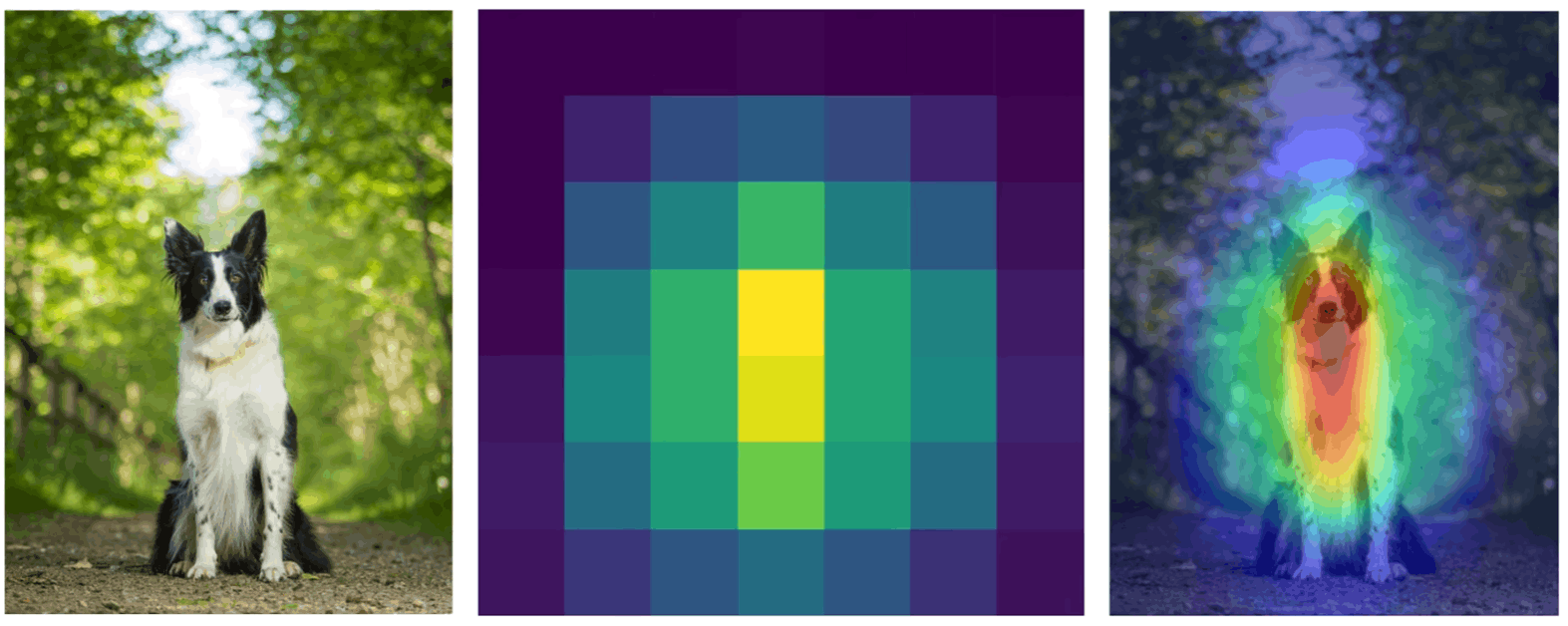

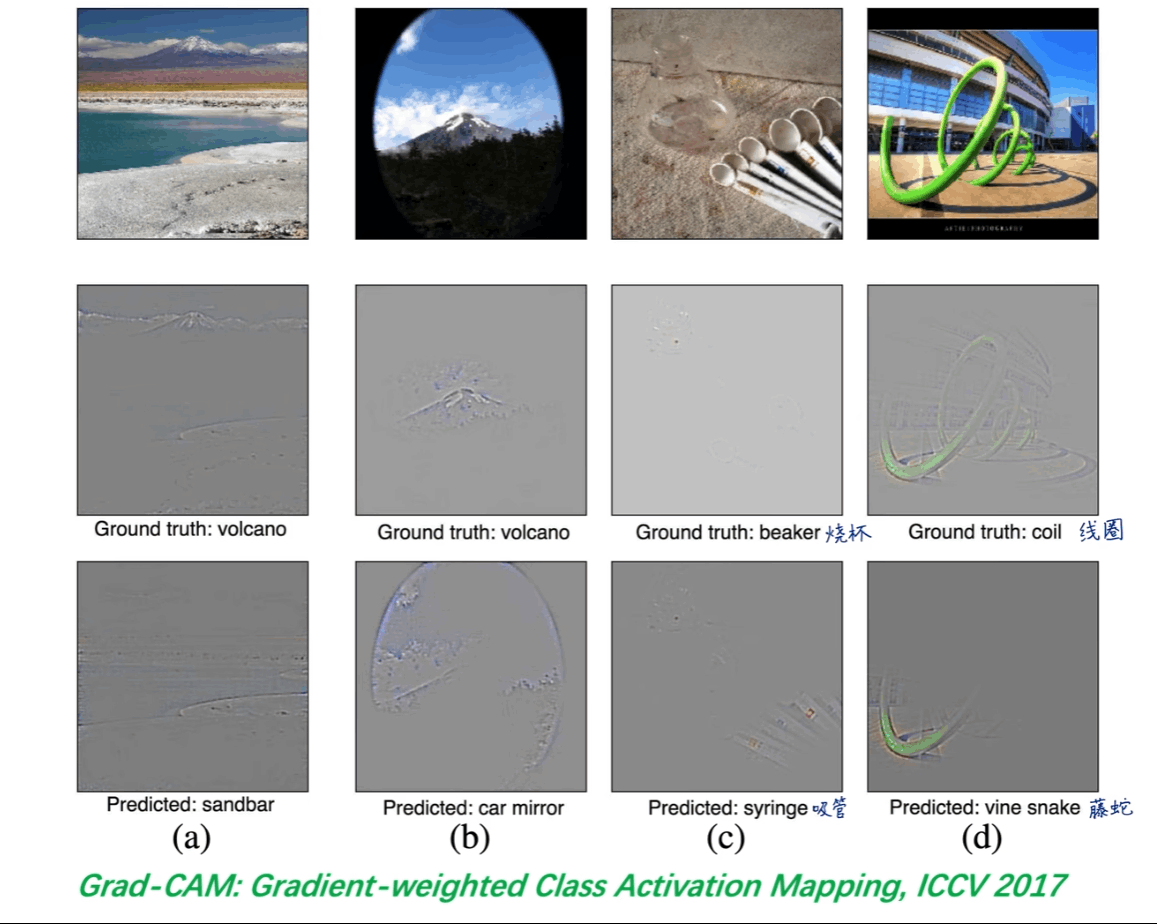

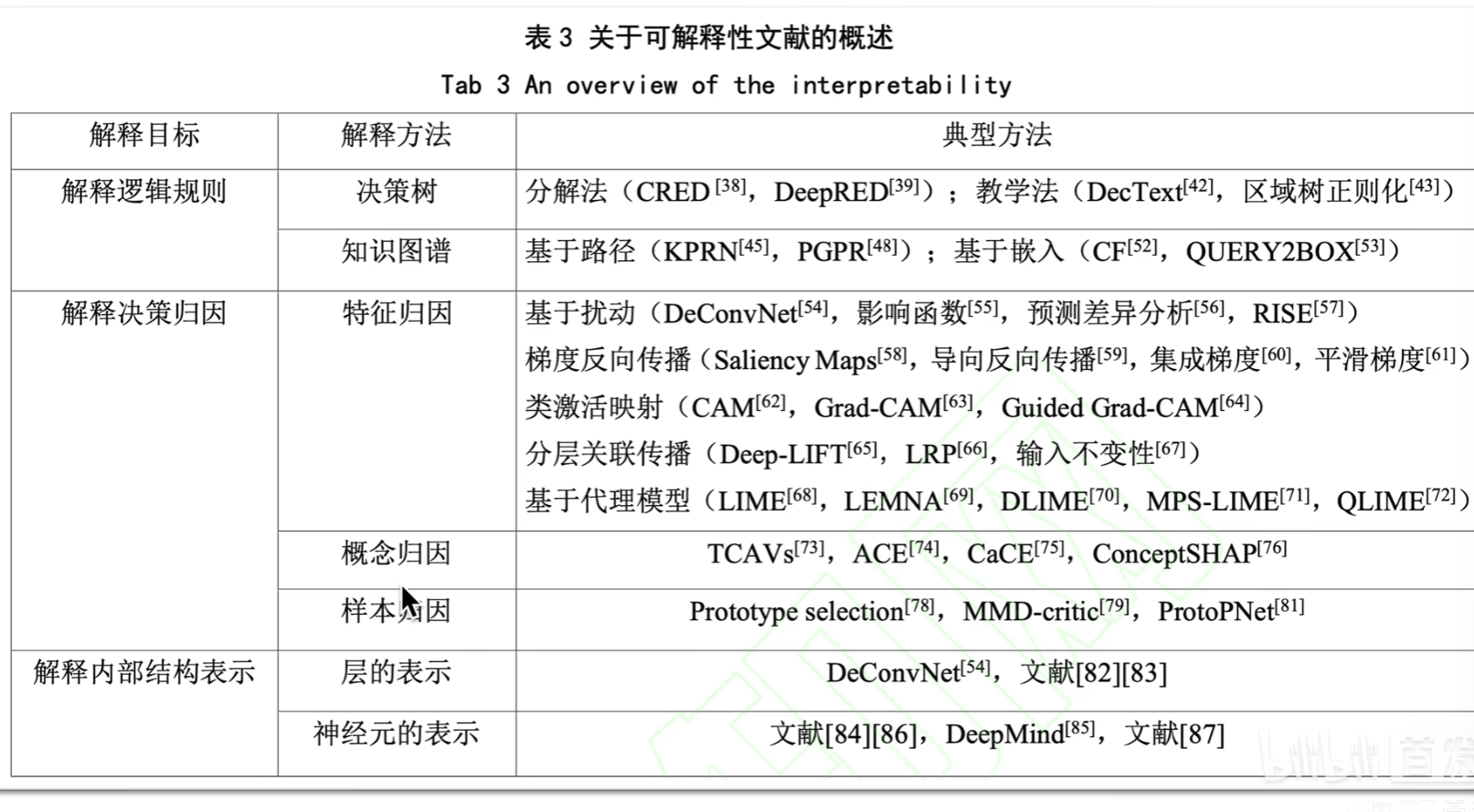

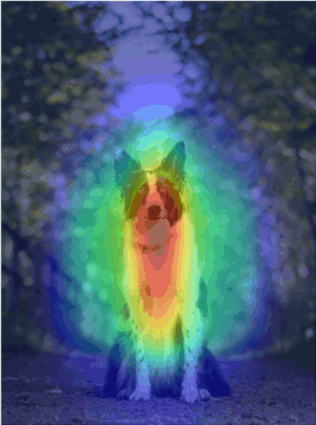

基于CAM的可视化

-

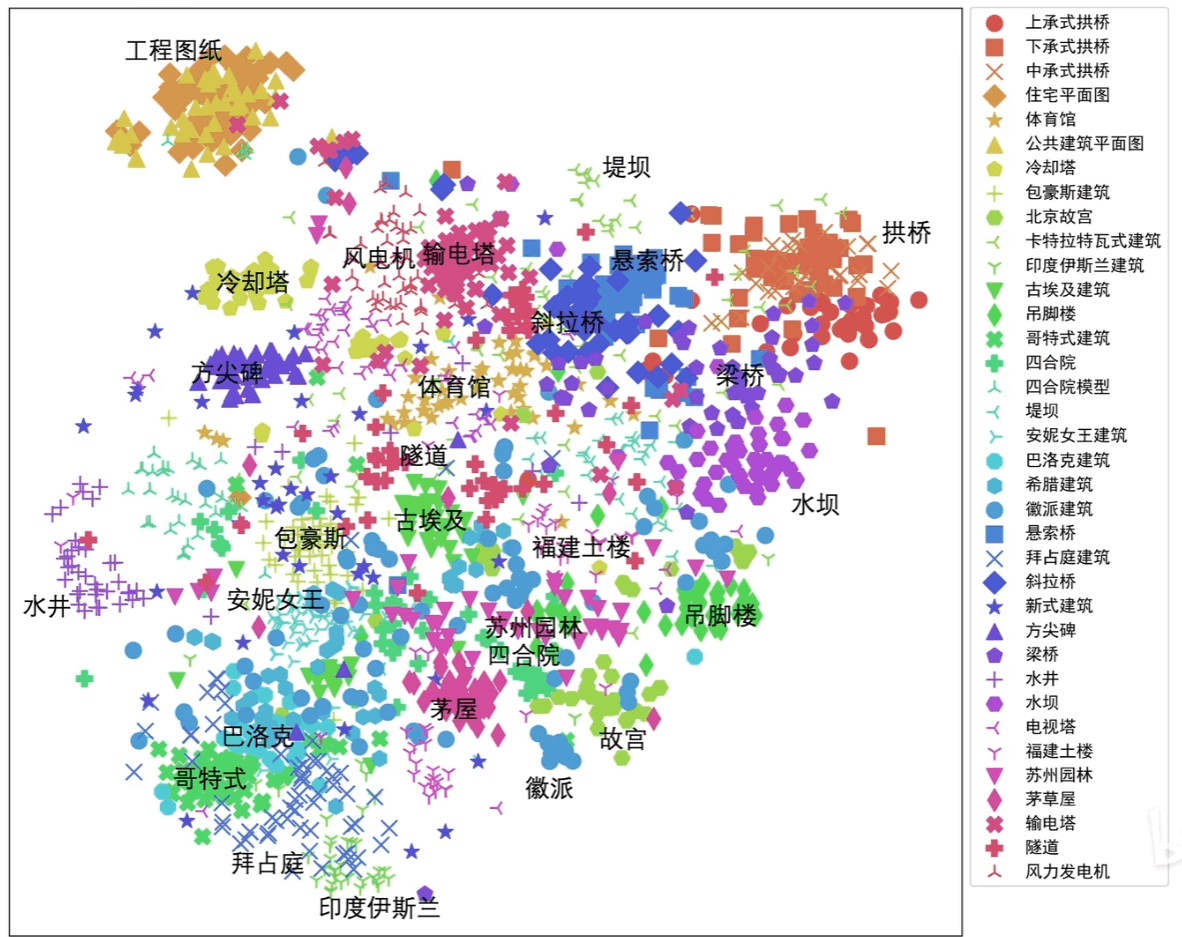

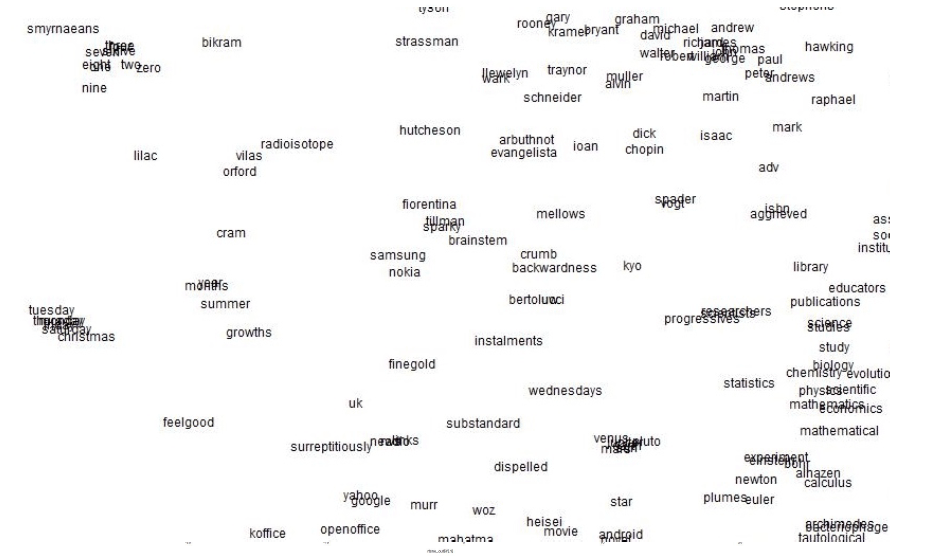

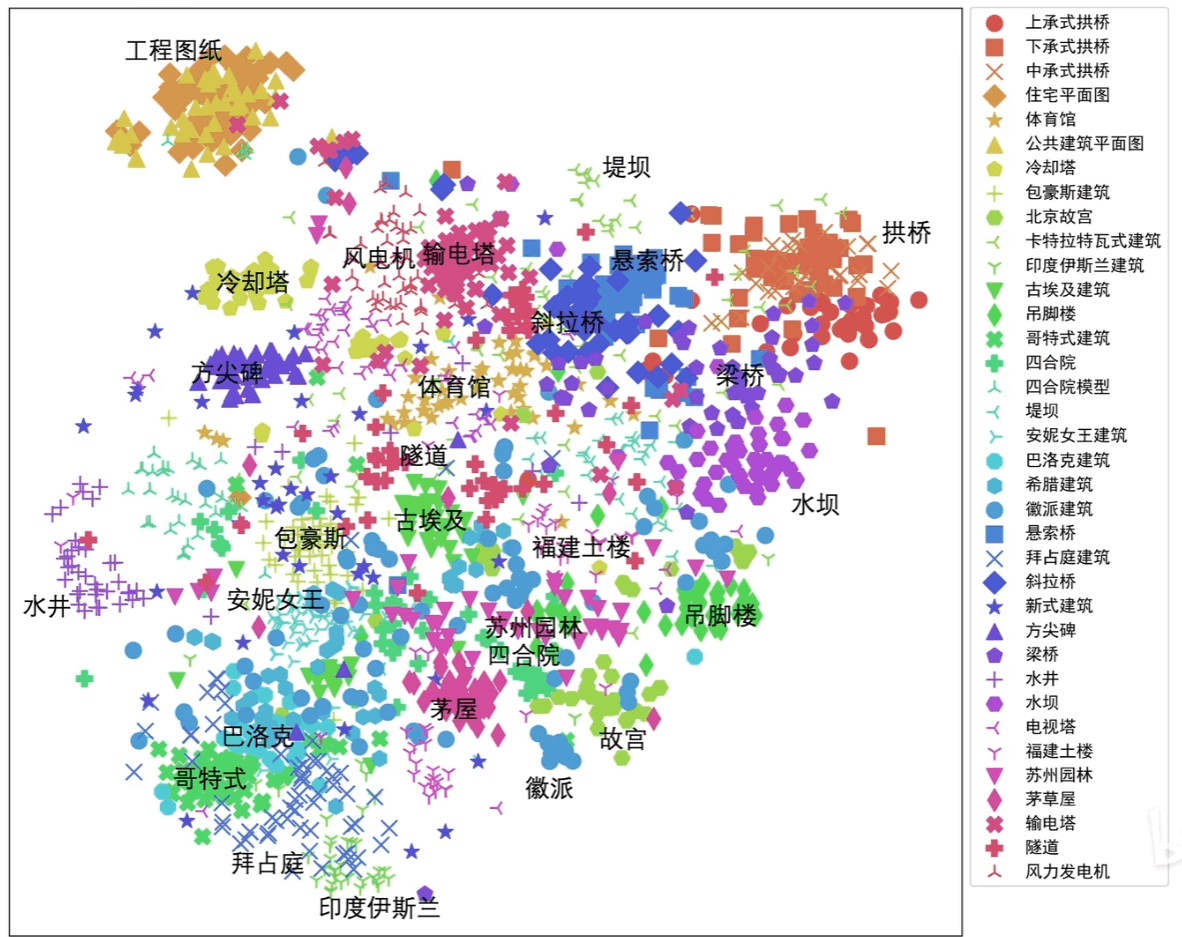

语义降维可视化

-

-

通过对高维样本特征降维到低维进行可视化,该分布和语义相关

-

eg.word2vec的词向量表示,降维后发现含义相近的在空间中分布靠近

-

生成满足需求的图像

-

通过优化样本使得的图像满足一定的需求,比如某个神经元激活最大或者

某个类别预测最大

-

应用场景:对抗样本攻击

-

FGSM etc.

-

通过不断迭代样本,同时施加约束(最小扰动),使得模型误判

张子豪codebase

pytorch-cnn-visualizations

pytorch-grad-cam

torch-cam

相关论文

-

Deep Inside Convolutional Networks: Visualising Image Classification Models and Saliency Maps

-

Score-CAM: Score-Weighted Visual Explanations for Convolutional Neural Networks

-

“Why Should I Trust You?”: Explaining the Predictions of Any Classifier

-

Visualizing and Understanding Convolutional Networks

-

Show and tell: A neural image caption generator

-

LayerCAM: Exploring Hierarchical Class Activation Maps for Localization

-

Learning Deep Features for Discriminative Localization

-

Grad-CAM++: Generalized Gradient-Based Visual Explanations for Deep Convolutional Networks

-

Grad-CAM: Visual Explanations from Deep Networks via Gradient-Based Localization

OpenMMLab 类别激活热力图可视化工具介绍

DataWhale 6个机器学习可解释性框架!

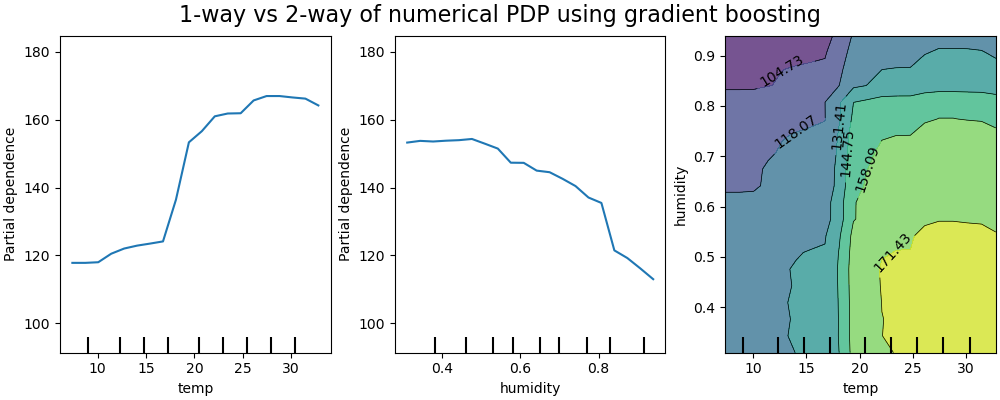

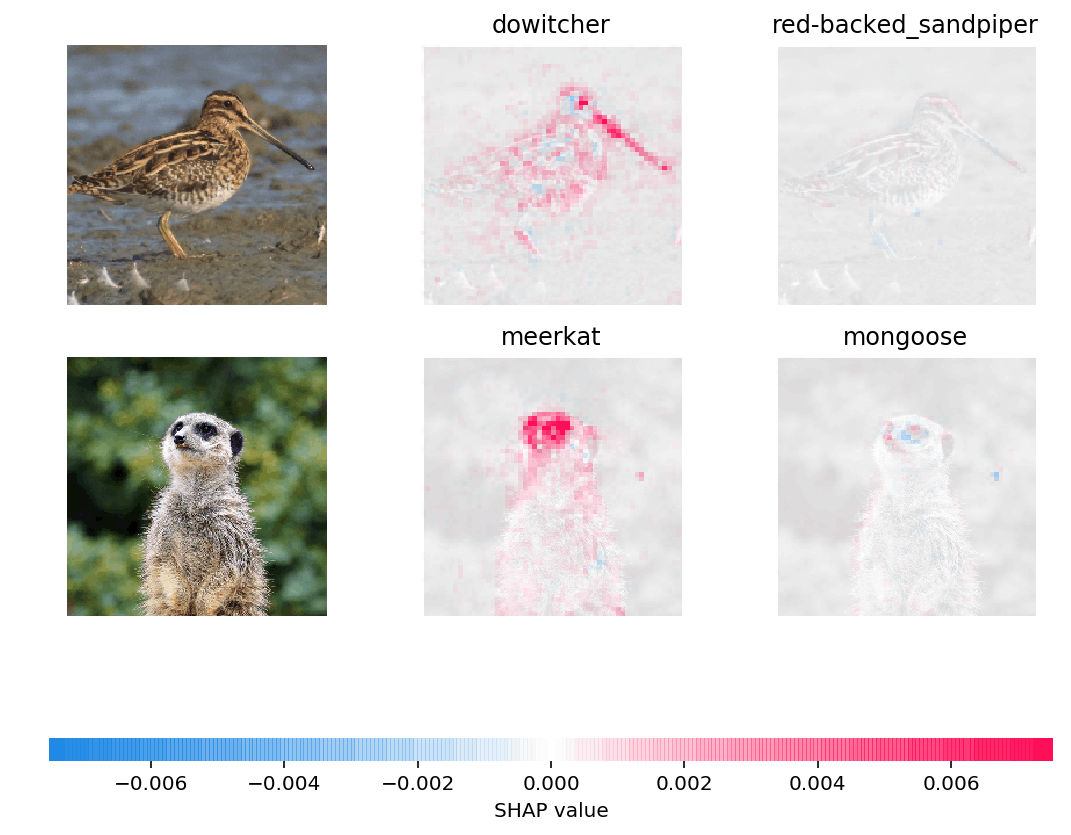

本文主要演示了对shap、LIME两个工具包的使用

shap是一种解释任何

机器学习

模型输出的博弈论方法,它利用博弈论中的经典Shapley值及其相关扩展将最优信贷分配与局部解释联系起来。

LIME帮助解释学习模型正在学习什么以及为什么他们以某种方式预测。目前支持对表格的数据,文本分类器和图像分类器的解释。

白毛偷二: