如何理解Tesla和Wayve在CVPR2023 workshop上提到的world model?

7 个回答

发展太快了。。。一个月前,我还在这里搞什么展望:

结果CVPR一开,忽然跳出一堆人纷纷表示我们都在搞。。。

World Model是杨立昆“ 通往自主机器智能的道路 ”一文的中心议题:

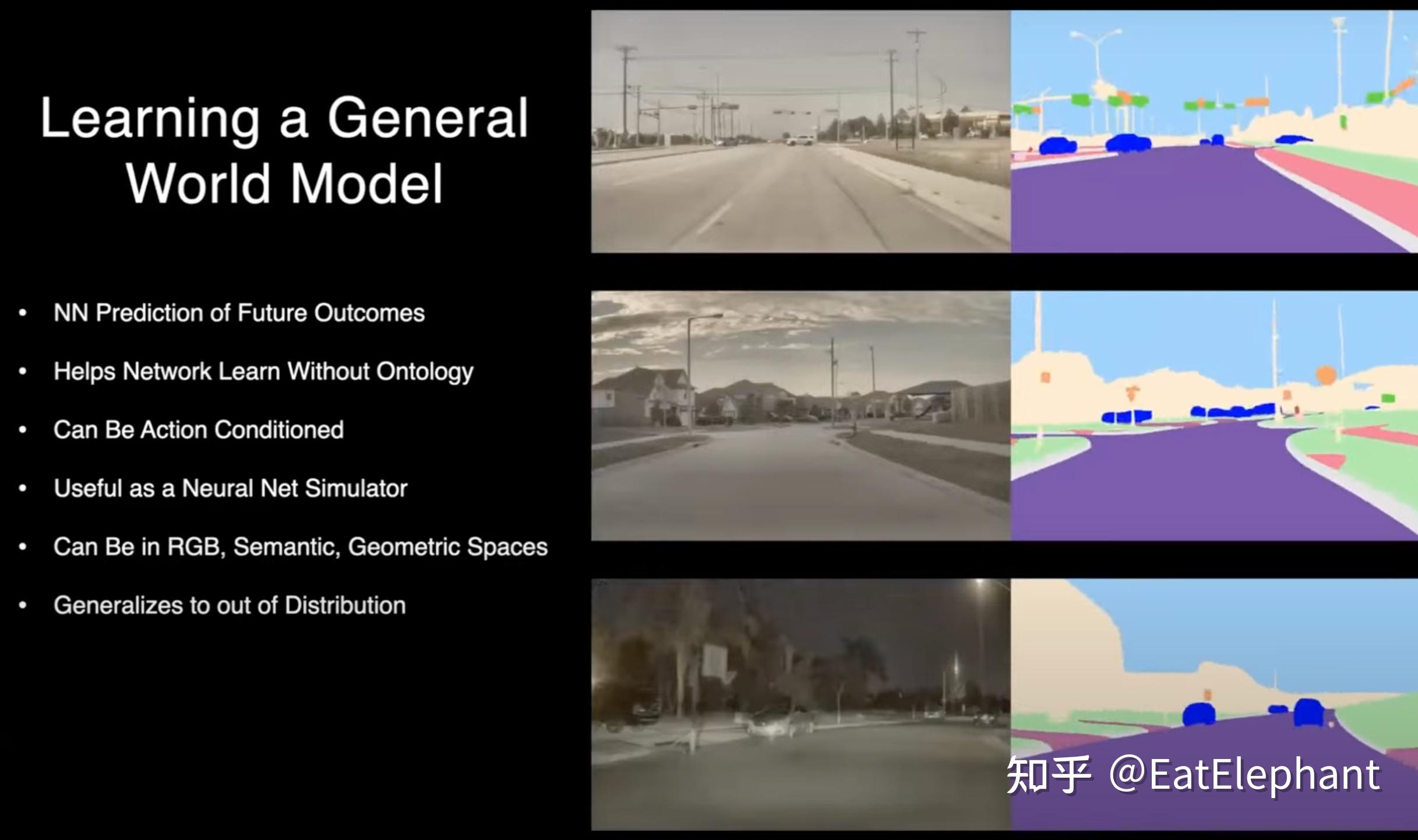

现在这个世界模型已经呈现百花齐放之势,不仅仅是特斯拉和Wayve哦,CMU,伯克利也都发表了各自的世界模型。总的来说世界模型是这样的一个东西:

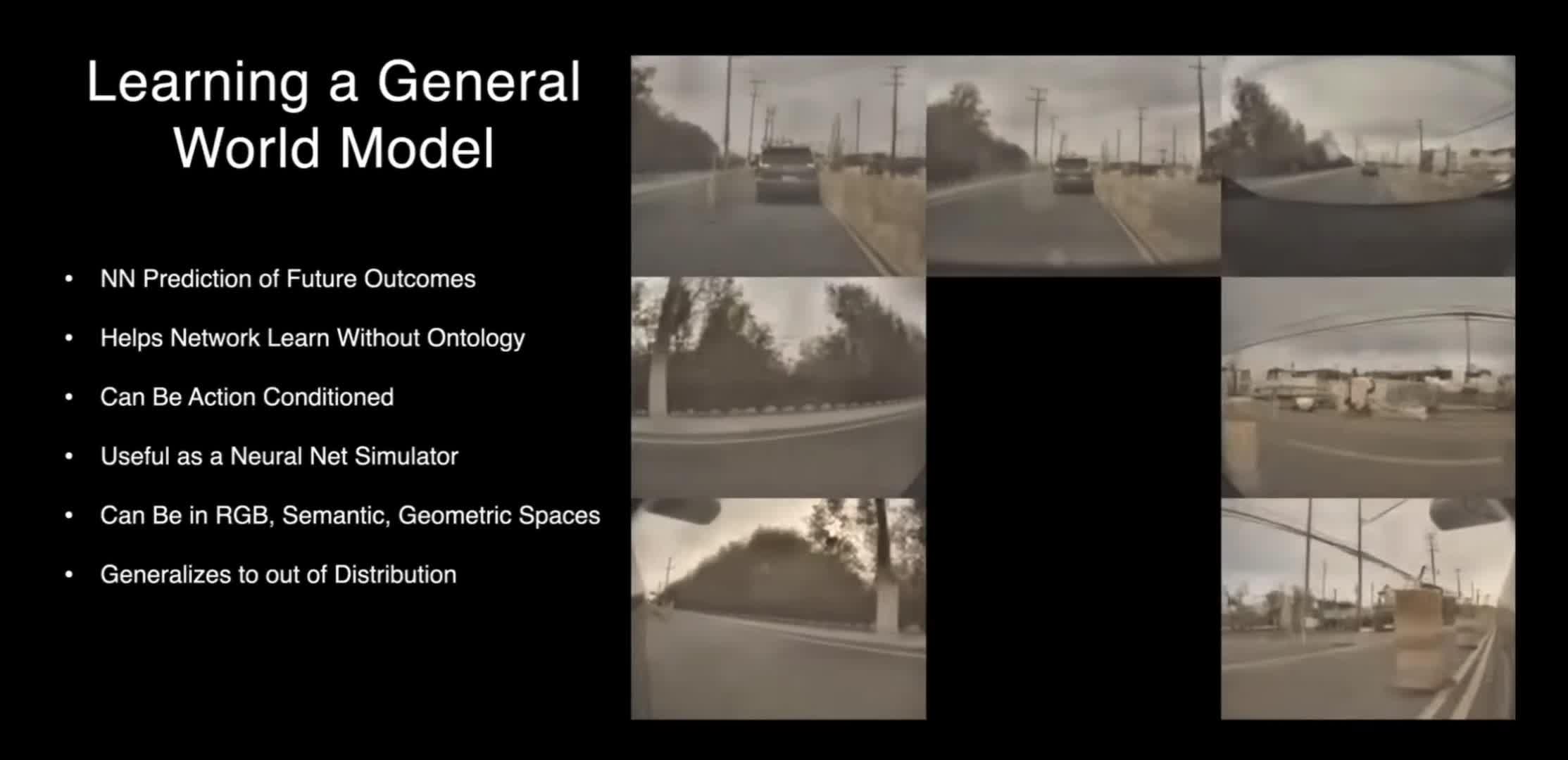

他能够通过一段多模态视频来感知并理解整个场景,包括形成对场景的三维理解,并能根据输入的控制或文字提示预测当前场景在未来的演化,最终要能生成不同传感器对未来场景的观测数据。

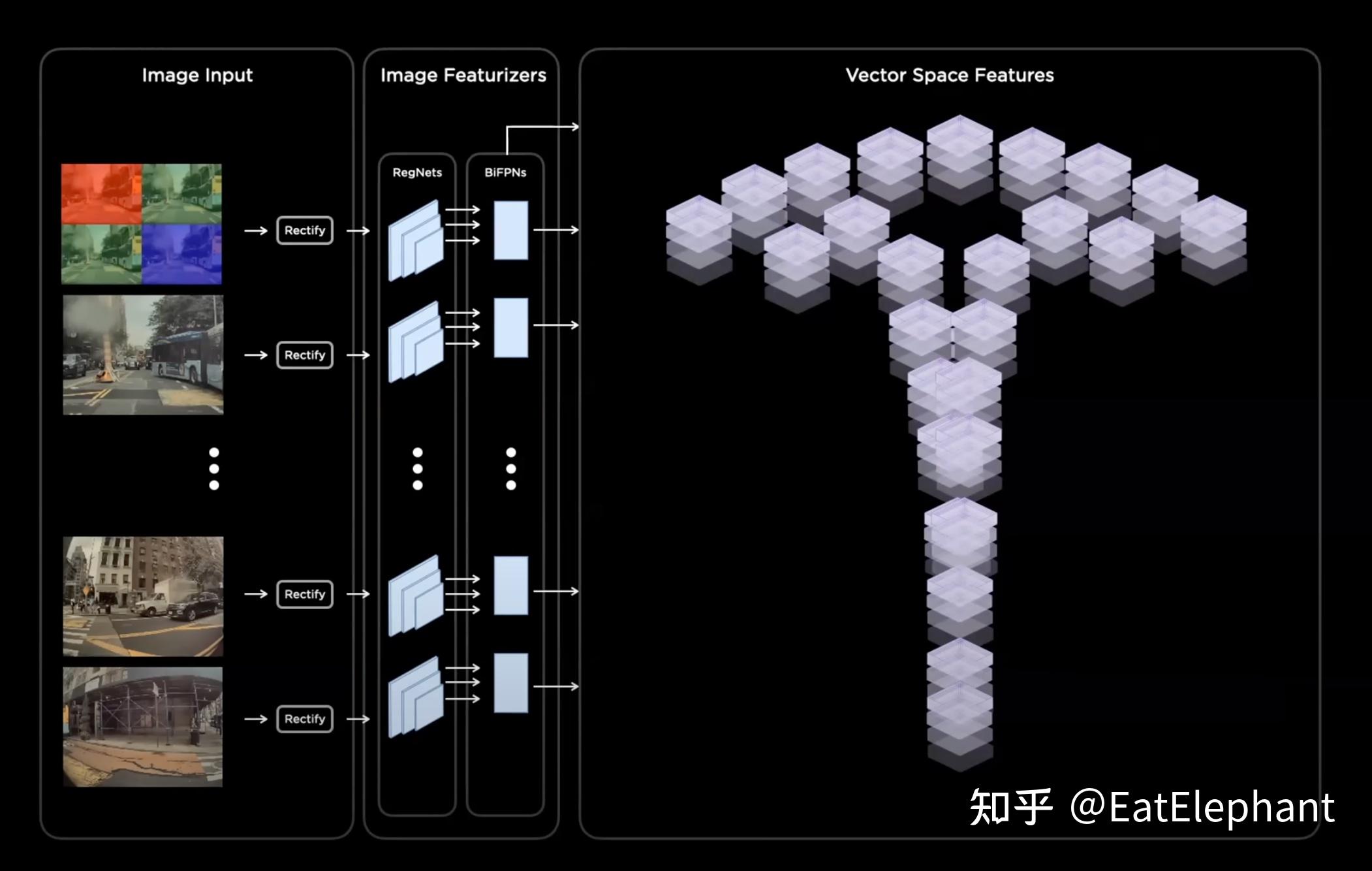

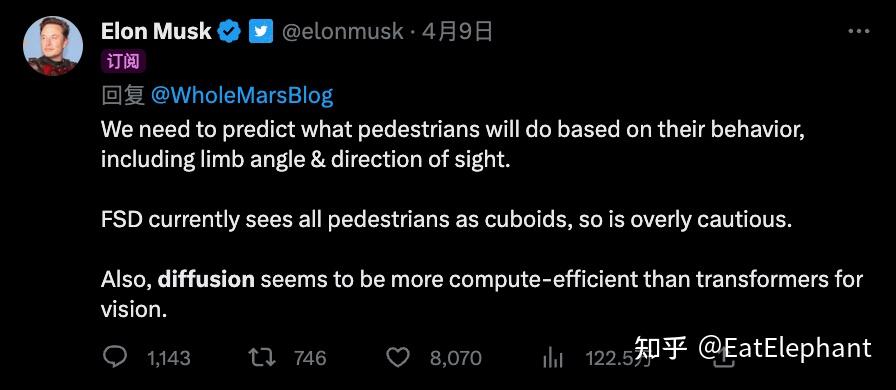

世界模型是机器人领域(包括自动驾驶)常见的概念,机器人系统一般都是由多模态输入->感知->世界模型->未来预测->规划控制这样的几个步骤组成的。而现在流行的世界模型,等于是要形成一个完全端到端的模型。而要将这些步骤全部融合在一起,这必然意味着模型要对整个场景拥有理解力,而且还要有一些和物理规则有关的基本知识,还要有语言能力来理解和控制有关的提示(比如换到右侧车道)。

假设我们真的训练出来了这么一个世界模型,那就意味着感知问题基本解决了。真的算是视觉的GPT时刻。CMU的演讲者甚至号称“training from scratch no longer makes sense”。也就是说以后你有什么具体的感知任务,基于世界模型微调一下就好了,针对某个任务重新训练没有意义了。

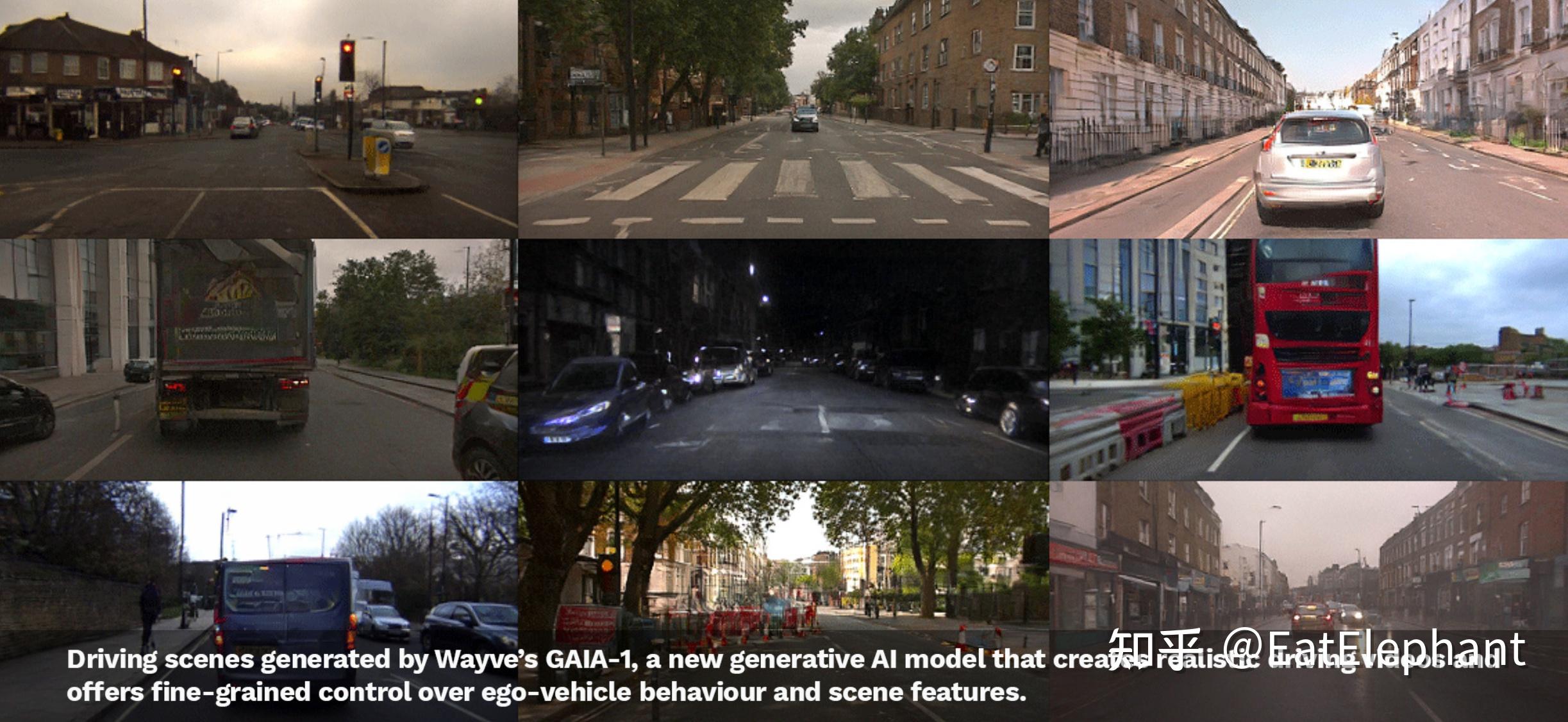

当然这都是美好的愿景,可惜就现在大家放出来的视频来看,都还不太行:

这些视频都存在一致性问题。很多细节,比如电线杆,车道线,车灯,车牌都是若隐若现,而且形态诡异。

除了一致性,模型还要能理解物理规律,比如如果有人踢了一脚足球,模型要能预测抛物线飞行轨迹。从现有视频看,模型只体现了对简单运动惯性的理解,能不能达到对物理规律的理解存疑。

只能说能有这个成果已经很厉害了,显然这个模型已经对场景形成了一定的理解,但顶多算是个PoC,还有很长的路要走。

而且怎么把世界模型对接到自动驾驶的系统中去,也有很多可能性,这大概也算是一个对齐的过程吧,到时候肯定会产生各种各样的做法。我们就看着他们做,等他们验证了可行性,一拥而上就完事了。