原标题:“鱼腹大考察”:《海底总动员》系列背后50件趣事

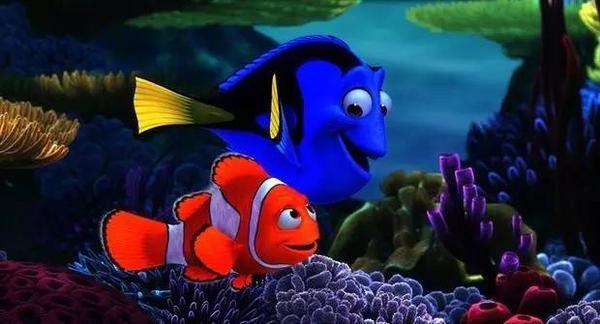

由皮克斯出品的动画力作《海底总动员2》已经于6月17日在中国内地和北美同步上映。续集中,小丑鱼父子马林和尼莫、健忘的蓝倒吊鱼多莉等角色悉数回归,将掀起一场全新的海底冒险。

13年前的《海底总动员》打破了美国电影史上的多项纪录。13年后,续集《海底总动员2》也承载着观众对前作的信心,被认为将成为今年北美暑期档的最大赢家,预测首周末票房将同它的前作一样,创造动画影史最高开画纪录。

在影片上映之际,时光网找出了《海底总动员》系列的50件趣事,或帮你梳理回顾13年前那场寻子之旅,或为你挖掘出这部最新续集的精彩所在。

★数说《海底》系列★

1、《海底总动员》是皮克斯第一部获得奥斯卡最佳动画长片的作品。

2、《海底总动员》是皮克斯第一部“见血”的电影,来自多莉的鼻子。

3、《海底总动员2》是皮克斯第3部以女性为主导的电影,此前两部是《勇敢传说》和《头脑特工队》。

4、《海底总动员2》是皮克斯第3部以首部配角作为主角的续集电影。在第一部里,多莉是马林的陪衬,而在第二部中多莉则成了主角。而之前出现这种主配颠倒情况的两部续集电影分别是《怪兽大学》和《

赛车

总动员2》。

5、多莉是皮克斯最受欢迎的角色,她在Facebook上拥有超过2500万个“赞”,是迪士尼和皮克斯旗下在Facebook上集赞最多的角色。

6、《海底总动员》最初从1997年开始准备,2000年投入制作,制作组超过180人。

7、《海底总动员2》的故事发生在第一部的1年后,而作为电影,影片与第一部之间隔了13年之久。

8、安德鲁·斯坦顿第一次构想出《海底总动员2》的剧情是在2010年,那时他公映后7年后第一次重看《海底总动员》。当他看的时候,突然想到如果多莉与马林和尼莫走失后还能找到他们吗?然后他就知道续集就应该讲这个故事。

9、在制作《海底总动员》中水母场面时,皮克斯专门负责海洋部分的动画师创造了一种全新的阴影方法,叫做模糊透视法(transblurrency)。用这种方法制作出来的画面既透明但又很模糊,就像被冻住的浴室玻璃。影片中整个水母区拥有74472只水母,每个镜头中都有超过8000只水母。

10、在《海底总动员》海龟迁徙的画面背景中,一共有200只海龟,虽然影片中没有说它们会游到哪里,但在DVD版本中主创透露它们的目的地是

夏威夷

。

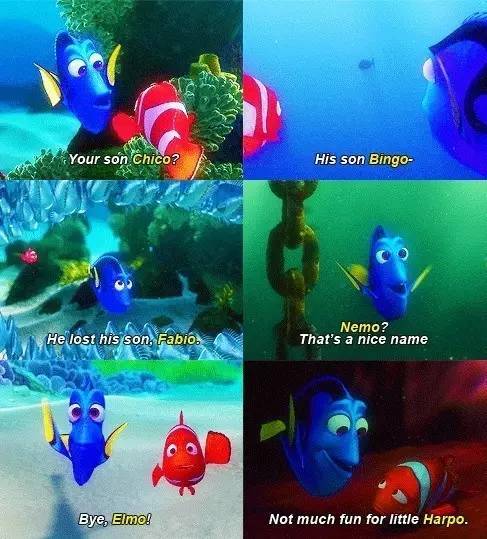

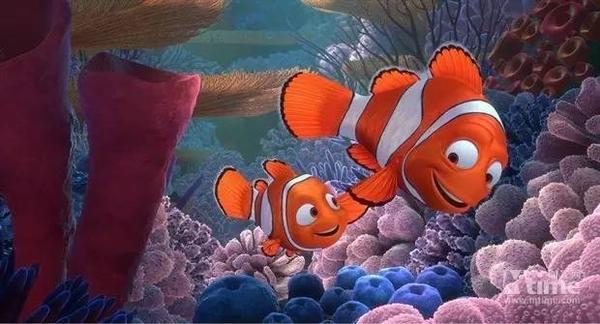

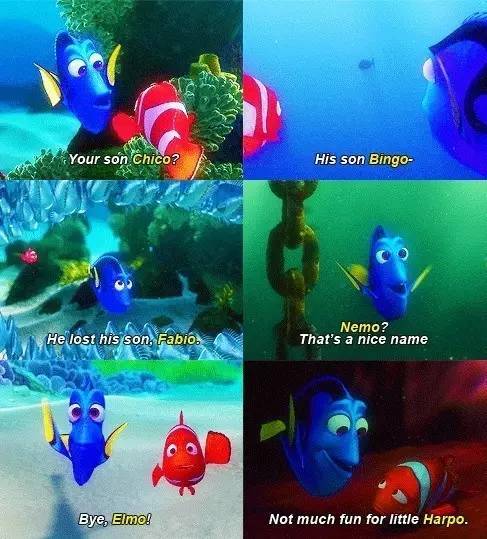

多莉因为健忘总是把尼莫的名字叫错

11、多莉在《海底总动员》中只叫对7次尼莫的名字,其中四次多莉原本叫错了后来又改过来了。不过由于健忘,多莉给尼莫改了一堆名字,分别是:Chico, Fabio, Bingo, Harpo, 和Elmo。

12、渲染一帧画面一般需要1/24秒,而在制作《海底总动员》时一帧需要渲染4天时间,因为水下环境、水下透光和鱼群呈现起来都太复杂了。

13、而到了《海底总动员2》,皮克斯创作团队光是设计出影片每一帧画面,就花了3年半的时间。

14、《海底2》中,多莉第一次来到海洋生物研究所的镜头一同拍了145次,花费了18位艺术家和动画师共13个月的时间。

15、《海底总动员》中牙医的相机上印着A-113,《海底总动员2》中卡车车牌号是CALA113。A113的组合出现在皮克斯所有电影中,指的是加利福尼亚艺术大学(CalArts)的一间教室,皮克斯工作室很多动画师都在那里学习过。

16、章鱼汉克是皮克斯历史上最难做的一个动画角色。为了这个形象皮克斯团队用了一年时间来制作,而主创花费六个月才做出他的一个镜头。皮克斯希望汉克的动作可以自然一些,每个动作都能用上他所有的触角,但是这个设想执行起来一点都不简单。

★角色冷知识★

左图:《怪兽电力公司》小女孩把尼莫形象的玩具递给毛怪;右图:《海底总动员》中小男孩手中的漫画是《超人总动员》里的主角

17、皮克斯通常会提前很多年就设计出未来电影里的角色。尼莫第一次在大银幕的亮相是在《怪兽电力公司》里,这一形象作为小女孩房间

沙发

上的玩具首次登场。有趣的是《海底总动员》里面也出现了皮克斯未来电影中的角色,牙医工作室的小男孩读的漫画是Mr. Incredible,这位也就是后来《超人总动员》的主角。

18、《海底总动员》里的大白鲨叫做Bruce,Bruce原来是《大白鲨》里那只鲨鱼模型的昵称,名字还是史蒂文·斯皮尔伯格以他的律师Bruce M. Ramer命名的。

19、主创们在设计马林和多莉时,就计划让两个角色拥有相反的个性,而他们的颜色——橘色和蓝色,也正好成反色。

20、多莉患有的短期记忆丧失症,来自主创对广泛误传的“金鱼只有三秒记忆”这一认知的调侃。

21、两部影片中的海鸥造型都参考了《超级无敌掌门狗》中的企鹅造型。

22、在拉丁语中,Nemo的意思是无名小卒,这个名字也致敬了儒勒·凡尔纳的《海底两

万里

》中的尼莫船长。

23、两只海龟的名字——Crush和Squirt,是美国两家最受欢迎的橘子汽水的品牌名。(PS:海龟Crush是不是有点神似“风骚律师”鲍勃·奥登科克?)

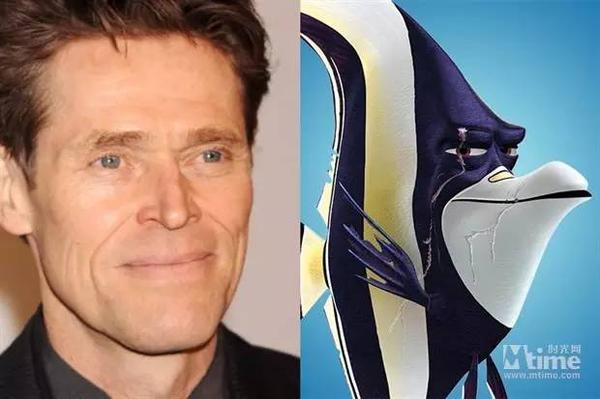

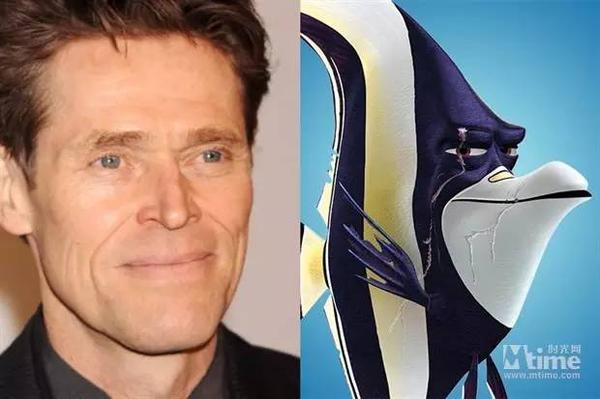

24、《海底总动员》里的刀疤鱼吉尔拥有黑白黄相间的颜色,他脸部设计参考了配音演员威廉·达福嘴边标志性的线条。

25、《海底总动员》系列的动物有各地的口音,比如第一部中的龙虾有波士顿的口音,因为负责制作影片的动画师之一就来自于马萨诸塞州,让片中小角色用家乡的口音也算是主创享有的小福利。到了第二部,两只海狮特地用了伦敦腔,导演想让这两个角色展现出伦敦街头小混混的感觉,所以找来伊德瑞斯·艾尔巴和多米尼克·威斯特为他俩配音,两位演员之前还一起合作过美剧《火线》。

26、《海底总动员2》中除了伊德瑞斯·艾尔巴和多米尼克·威斯特配音的两只海狮外,海洋生物研究所里还有第三只海狮,叫做杰拉尔德。巧合的是,第一部中差点吞掉马林和多莉的那只鹈鹕也叫杰拉尔德。(上图就是第一部中的杰拉尔德。)

27、《海底总动员2》中,海洋研究所展区里悬挂的一些模型都是第一部中出现过的海洋生物,比如水母和鲸鱼。

28、《海底总动员2》中的女性角色比第一部要更多,因为参与续集的女编剧更多了。

★幕后趣事知多少★

29、导演安德鲁·斯坦顿在两部《海底总动员》中都为海龟Crush配音。斯坦顿最初本来没想在成片里用自己的声音,只想在初剪时配着玩。但是配音在试映时很受欢迎,于是斯坦顿决定还是继续用自己的声音。后来他躺在自己的办公室的沙发上完成了海龟的配音。

30、给《海底总动员》中海龟Crush儿子Squirt配音的是布拉德·伯德的儿子尼古拉斯·伯德。之前布拉德·伯德在皮克斯办公室给大家放自家拍的家庭DV,结果安德鲁·斯坦顿相中了伯德儿子的声音。

31、《无耻之徒》里的老爹威廉姆·H·梅西最初被指定为马林配音,他还录完了第一部所有台词和对白,不过最后他还是被艾伯特·布鲁克斯替代了。

32、《海底总动员2》中尼莫的配音换了人,原来为尼莫配音的亚历山大·古尔德已经长大了,声音也不再适合尼莫的设定,不过他还是为一名游客配了音。新版的尼莫由海登·罗伦斯配音。

33、《海底总动员2》是伊德瑞斯·艾尔巴在2016年参演的第三部迪士尼电影了,之前他在《疯狂动物城》和《奇幻森林》里分别为水牛局长和大反派老虎谢力·汗配音。

34、皮克斯动画师Glenn McQueen在制作《海底总动员》过程中去世,为了纪念他皮克斯就以McQueen作为《赛车总动员》里主角的名字。

35、《海底总动员》成功的关键在于水下世界给观众的直观感觉,为了保证逼真,主创们经常跑去参观水族馆,还特地去蒙特利和夏威夷潜水。皮克斯公司内部有一个25加仑的水族箱,动画师们经常在水族箱前开会研究各种鱼类,而且还被安排学了不少鱼类学知识。

36、为了准备制作马林和多莉被困在鲸鱼里的那组镜头,负责阴影效果的艺术总监罗宾·库珀和美工师伯特·贝利爬进了一只在马林郡北部搁浅死掉的灰鲸的体内。工作人员解剖了死鲸的尸体来研究它的结构——肌肉、心脏、鳃、鱼鳔等等。

37、制作《海底总动员》时,主创们本来已经制作出了特别写实特别逼真的海洋表面的画面,但由于害怕观众以为他们用了实物镜头,团队不得不把画面弄的假一点。

38、动画师们在创作《海底》时学习了狗的表情,观察狗狗眼睛的变化,然后再把这些运动和反应运用到鱼身上。

39、以“研究”之名,约翰·拉赛特坚持让《海底》主创考了潜水证,还让他们去大堡礁潜水。

40、《海底总动员》中展现海浪动画的电脑程序曾在《怪兽电力公司》中用来做Sully的头发。

不被看好的《海底总动员》却成为当年最受欢迎的动画作品

41、《海底总动员》最初被前迪士尼CEO认为会是一部失败的电影。根据James Stewart所著的一本名叫《迪士尼之战》的书里透露,在看完由梅西配音的初剪版后,当时迪士尼CEO迈克尔·埃斯纳私下跟董事会成员们表示,这部电影肯定会扑街:“电影挺好的,但是没法跟皮克斯之前的电影比。当然他们觉得这部电影很棒,但相信我,它根本不行。”后来导演安德鲁·斯坦顿让艾伯特·布鲁克斯重新配音,而影片上映后得到了皮克斯动画有史以来最好的评价,也在当时成为影史上票房最高的动画电影。

42、为准备《海底总动员2》,包括导演在内的主创都参观了加利福尼亚蒙特雷湾海洋生物研究所,这里最终成为电影故事的发生地。

《黑鲸》剧照

43、第二部的故事原本设定在海洋公园内,但是皮克斯的员工们在观看了具有争议性的纪录片《黑鲸》后,将故事地点换成了海洋生物研究所。这部《黑鲸》讲的是海洋娱乐产业背后的残酷真相,在高利润面前迷失心智的工作人员残酷对待海洋物种的现状。

44、约翰·拉赛特原本打算找丹尼·艾夫曼(《米尔克》《大鱼》《心灵捕手》》为《海底总动员》配乐,艾夫曼没有接受邀请推掉了这份工作。后来他又问了汉斯·季默,季默也拒绝了。最后拉塞特找到托马斯·纽曼为影片创作原创音乐,成片证明拉塞特没有选错人。影片还入围了2003年奥斯卡最佳配乐奖的提名。而托马斯·纽曼(《肖申克的救赎》《美国美人》)也将为续集继续配乐。

45、导演安德鲁·斯坦顿最初无法说服自己让多莉成为续集的主角,不仅因为她经常健忘,而且观众认为她有些傻乎乎的,把她看做影片的笑料。因此主创们花了很长时间来为她设置了很多自我反省的戏份,编剧则费了一番功夫来展示她的智慧,让她不至于显得太傻。

46、章鱼汉克为什么只有7只触手呢?《海底总动员2》中的角色都或多或少地有些缺陷,多莉有短期记忆丧失症,鲸鲨运儿得了高度近视,白鲸贝利的声波系统出了毛病,而“八爪鱼”汉克只有7根触角。皮克斯团队在设计这个角色时进行了分工,每个人负责汉克不同的部分,而当他们最后把各个部分组合在一起时,他们发现汉克的身体只有容纳7根触角的空间……所以编剧们不得不重写剧本解释汉克少根触角的原因(被熊孩子抓坏了)。

★电影之外的那些事★

47、美国加州雷德伍德城海湾地区有两条大道以多莉和马林的名字命名——多莉道和马林街。这两条街道和皮克斯总部只隔着一条海湾。

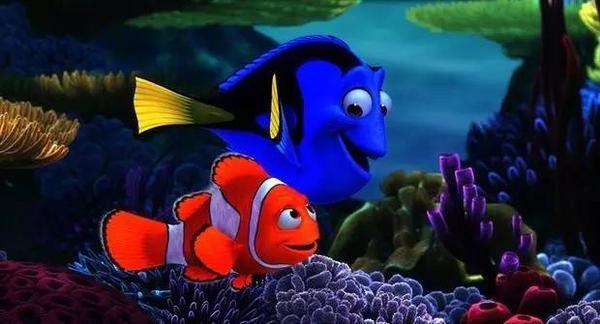

马林所属的小丑鱼和多莉所属的蓝倒吊鱼,在影片上映后成了热卖品

48、《海底总动员》一上映,美国当地的热带鱼就开始供不应求,需求量最大的是影片中俩主角的品种——小丑鱼和蓝吊鱼。但是也像片中的小孩Darla一样,很多宠物新手不知道怎么照顾好这些宠物鱼,所以最终把鱼养死的不在少数。人们最后发现生长在盐水里的热带鱼需要至少30加仑的水族箱,并且严格控制水中盐度,否则都会导致鱼死亡。

鱼类的供不应求让卖家大吃一惊,有的地方小丑鱼的数量下降了75%。这种情况虽然之前也曾发生过,但是《海底总动员》的情况非常特殊,毕竟影片主旨是动物不再成为宠物而追寻自由。一些观众get到影片的这个点,于是开始了放生行动,但是成果并不乐观:他们有的把鱼放入大海,结果造成佛罗里达地区的生态紊乱,有的人直接把鱼从厕所冲走,但是很多鱼还没游到下水道就死了。

49、为了防止孩子们学习《海底总动员》里尼莫从下水道逃生的做法,美国几家下水道修护机构联合发布了一项警告,要求小孩不要将宠物鱼从下水道冲走,虽然下水道都最终通向大海,但是管道中水流强劲,加上内部生长的一些植物,很有可能会把鱼给碾碎。

50、《海底总动员》上映之后,一名法国儿童图书作家起诉影片侵权。这位名叫Franck Le Calvez的作家在影片上映的一年前出国一本书,讲的是一只小丑鱼经历千辛万苦寻找他不熟悉的母亲的故事。事实上,这个故事原本是Calvez在1995年写的剧本,但是没人对故事概念感兴趣所以一直没有卖出去。在《海底总动员》上映后,Calvez起诉皮克斯侵犯故事版权,但是最终他连尝两次败诉,还被要求交纳8万美元的破坏费和法庭费用。

作者:皮冻