机器之心编辑部

来自东方理工的研究团队提出了一种广义流形对抗攻击的新范式,将传统的 “点” 攻击模式推广为 “面” 攻击模式。

声称准确率 99% 的人脸识别系统真的牢不可破吗?事实上,在人脸照片上做一些不影响视觉判断的改变就可以轻松攻破人脸识别系统,例如让邻家女孩和男明星被判断成同一个人,这便是对抗攻击。对抗攻击的目标是寻找自然的且能够让神经网络混淆的对抗样本,从本质上讲,

找到对抗样本也就是找到了神经网络的脆弱之处。

近日,来自东方理工的研究团队提出了一种广义流形对抗攻击的范式(Generalized Manifold Adversarial Attack, GMAA),

将传统的 “点” 攻击模式推广为 “面” 攻击模式

,极大提高了对抗攻击模型的泛化能力,为对抗攻击的工作展开了一个新的思路。

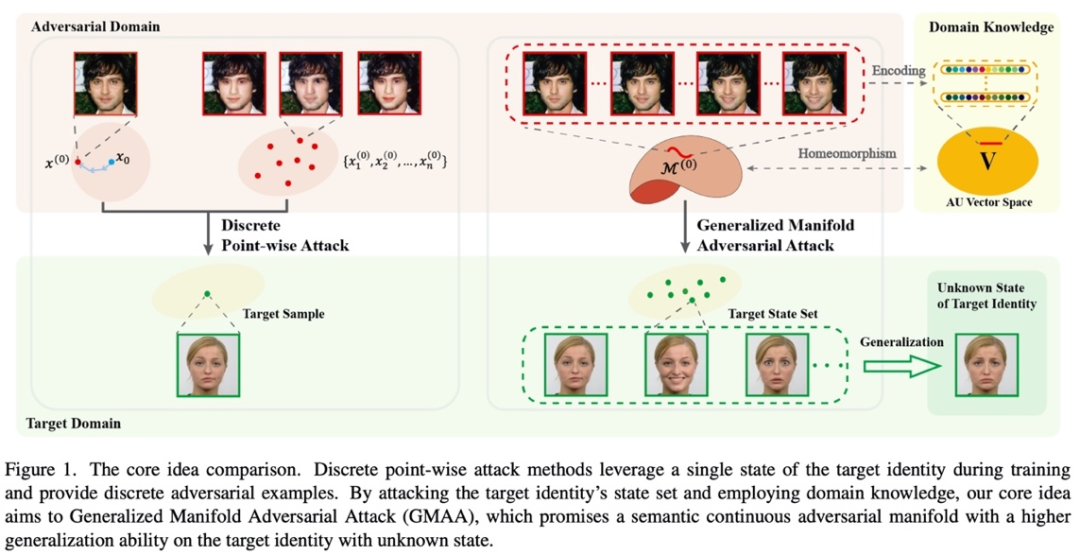

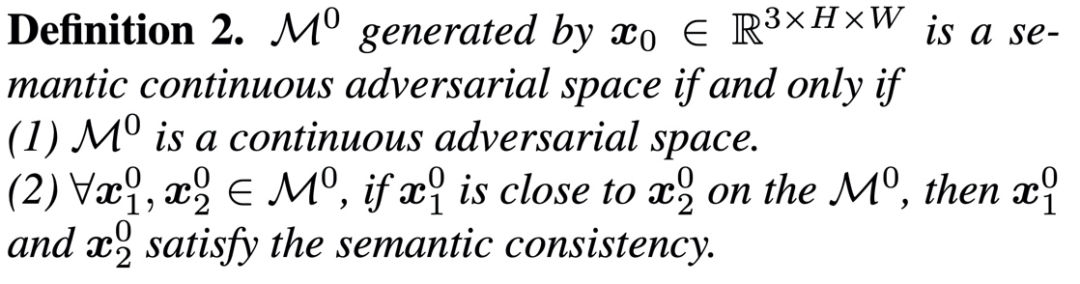

该研究从目标域和对抗域两个方面对先前的工作做了改进。在目标域上,该研究通过攻击目标身份的状态集合找到高泛化的更强大的对抗样本。对于对抗域,先前的工作都是在寻找离散的对抗样本,即找到了系统的几个 “漏洞”(点),而该研究则在寻找连续的对抗流形,即要找到神经网络脆弱的整片 “区域”(面)。此外,该研究引入表情编辑的领域知识,提出了基于表情状态空间实例化的新范式。通过对生成的对抗流形连续采样可以获得表情连续变化的高泛化性对抗样本,相比于化妆、光照、添加扰动等手段,

表情状态空间更加普适自然,不受性别、光照的影响。

研究论文已被 CVPR 2023 接收。

论文链接:

https://arxiv.org/abs/2301.06083

代码链接

https://github.com/tokaka22/GMAA

方法介绍

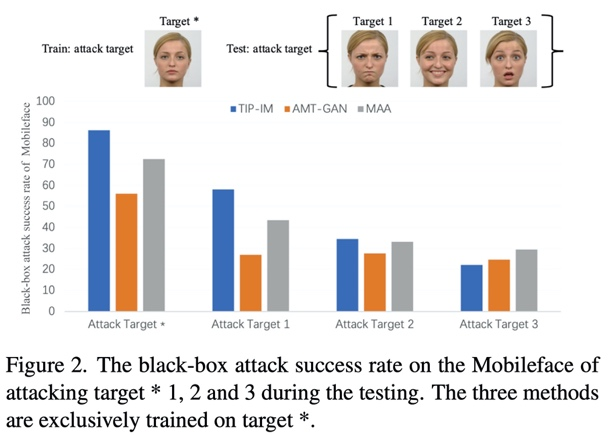

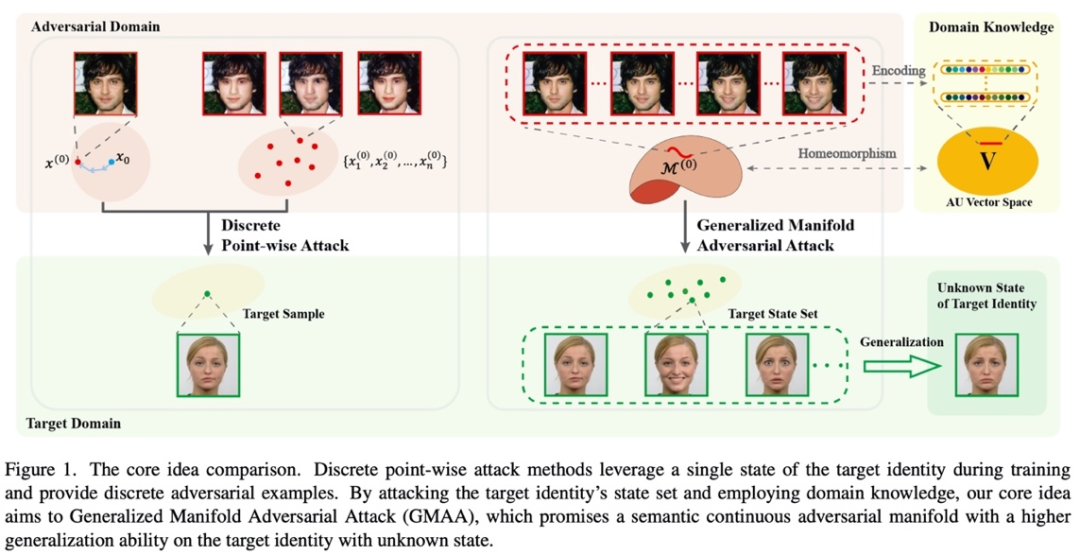

在目标域部分,先前的工作都是针对目标身份 A 的某一张特定的照片去设计对抗样本。但是如图 2 所示,当用这种攻击方式生成的对抗样本去攻击 A 的另一张照片时,攻击效果会大幅下降。面对此类攻击,定期更换人脸识别库中的照片自然是一种有效的防御措施。但是,该研究提出的 GMAA 不仅针对目标身份的单个样本进行训练,而且寻找能攻击目标身份状态集合的对抗样本,

这样的高泛化性的对抗样本面对更新后的人脸识别库具备更好的攻击性能。

这些更强大的对抗样本也对应着神经网络更为薄弱之处,值得深入探索。

在对抗域部分,先前的工作都是寻找离散的一个或几个对抗样本,这相当于在高维空间中找到了神经网络脆弱的一个或几个 “点”,而该研究认为,神经网络可能在一整个 “面” 上都是脆弱的,应该将这个 “面” 上的对抗样本 “一网打尽”。因此,该研究致力于寻找高维空间中的对抗流形。

综上,GMAA 是一种用

对抗流形去攻击目标身份的状态集合

的新攻击范式。

文章的核心思想如图 1 所示。

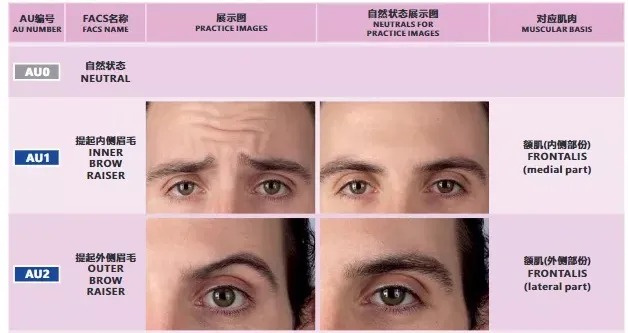

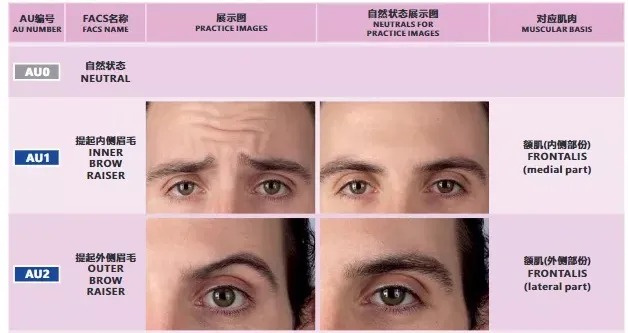

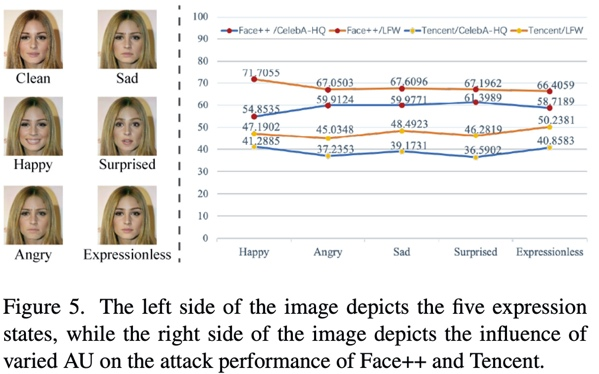

具体来说,该研究引入表情编辑的领域知识 Facial Action Coding System (FACS),用表情状态空间来实例化所提出的新攻击范式。FACS 是一种面部表情编码系统,它将面部分为不同的肌肉单元,其中 AU 向量中的每个元素都对应了一个肌肉单元,向量元素值的大小表示了对应单元的肌肉活跃程度,从而编码表情状态。例如下图中,AU 向量中的第一个元素 AU1 表示了提起内侧眉毛的程度。

来自《面部表情解剖学》

对于目标域,该研究攻击含有多种表情状态的目标集合,从而实现对未知的目标照片也有较好的攻击性能;对于对抗域,该研究建立与 AU 空间一一对应的对抗流形,可以用改变 AU 值的方式,在对抗流形上采样对抗样本,连续地改变 AU 值,就可以生成表情连续变化的对抗样本。

值得注意的是,该研究采用表情状态空间来实例化 GMAA 攻击范式。这是因为表情是人面部活动中最常见的一种状态,而且

表情状态空间相对稳定,不会受到人种、性别的影响(光照可改变肤色、化妆则会影响性别)

。事实上,只要能找到其他合适的状态空间,该攻击范式就完全可以被推广应用于自然界的其他对抗攻击任务中。

模型结果

下面的动图展示了该研究的可视化结果。动图的每一帧都是在对抗流形上采样得到的对抗样本,连续地采样就可以获得表情连续改变的一系列对抗样本(左侧),红色的数值表示当前帧的对抗样本与目标样本(右侧)在 Face++ 人脸识别系统下的相似度。

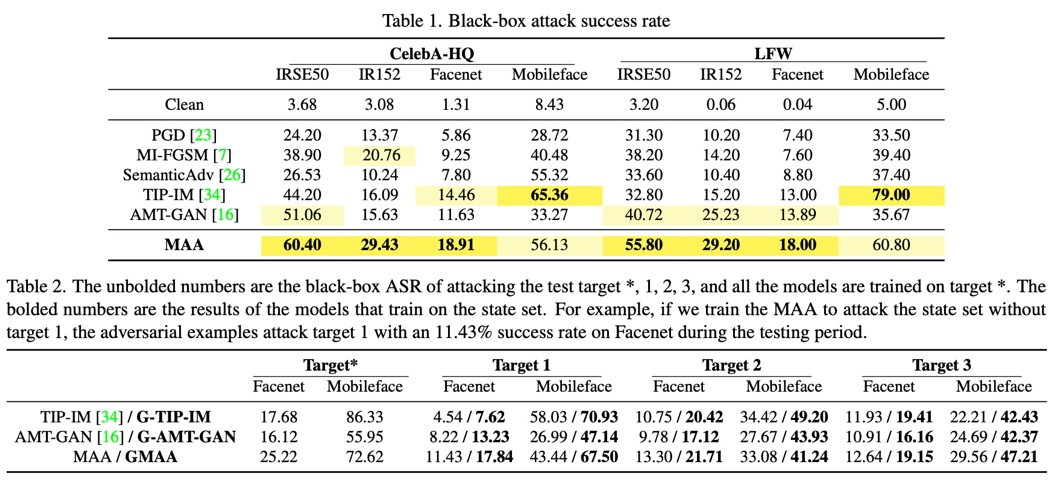

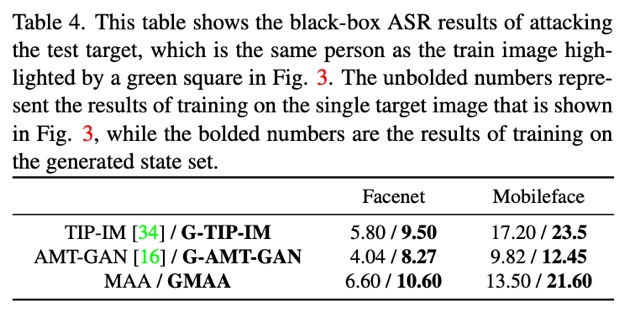

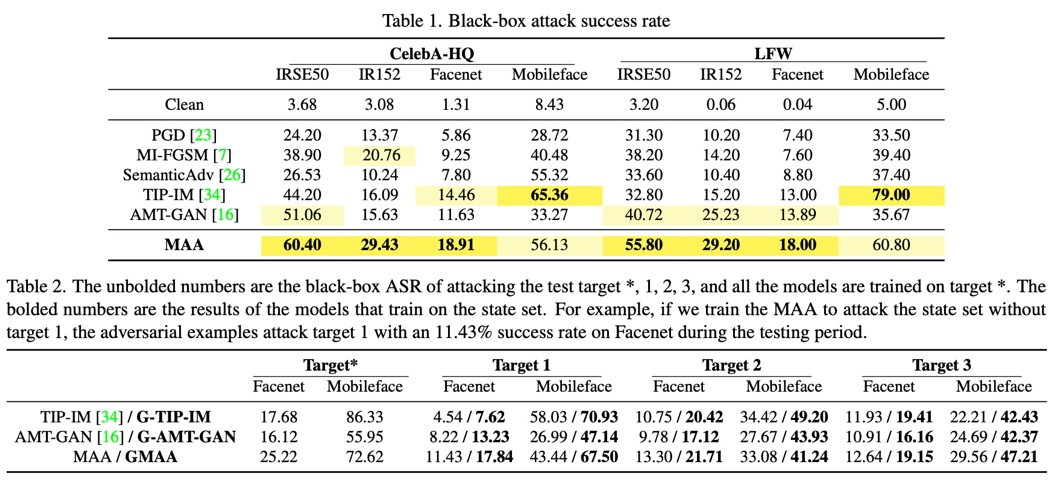

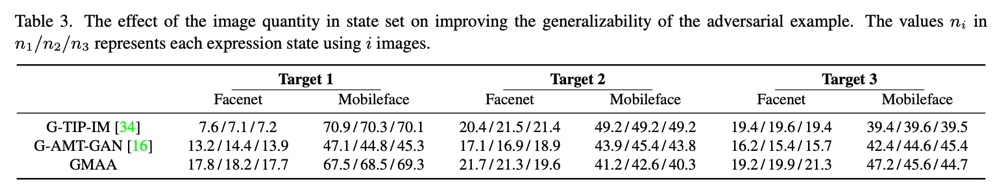

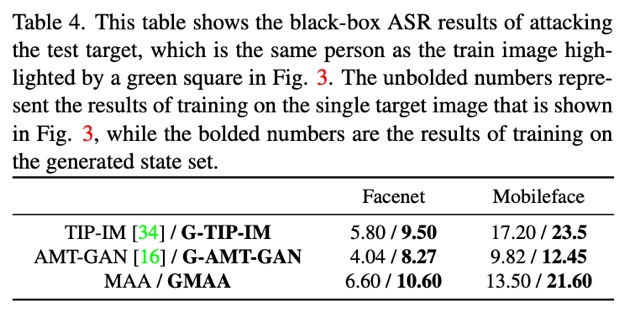

在表 1 中,研究列出了 4 个人脸识别模型在两个数据集上的黑盒攻击成功率,其中,MAA是GMAA的缩减版,MAA仅在对抗域上将点攻击的模式推广到了流形攻击,目标域上依然是对单个目标照片进行攻击。攻击目标的状态集合是一种通用的实验设置,文章在表2中为包括MAA在内的三种方法加上了这种设置(表中加粗的部分是加上这种设置的结果,在方法的名称前加上了“G”以示区分),验证了目标域的扩充可以提升对抗样本的泛化性。

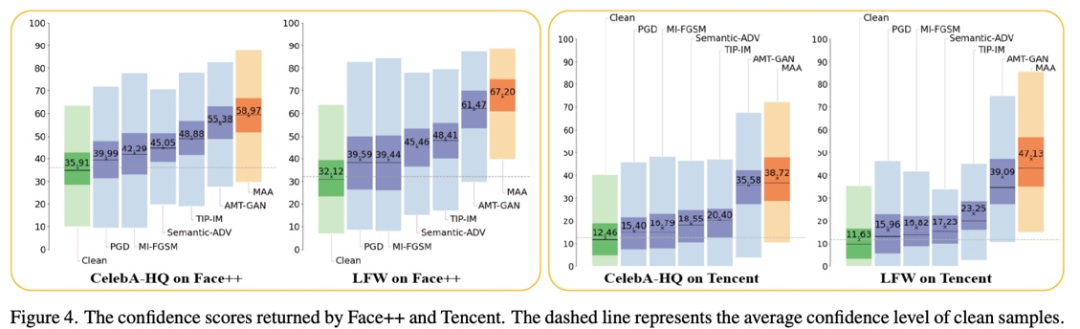

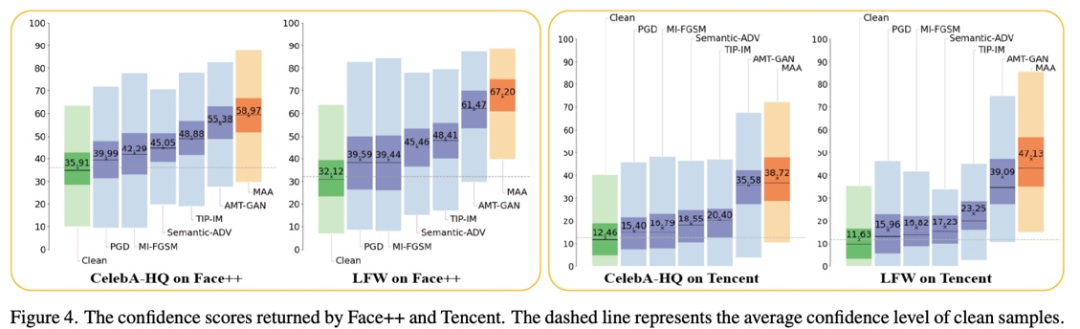

图 4 展示了攻击两个商业人脸识别系统 API 的结果。

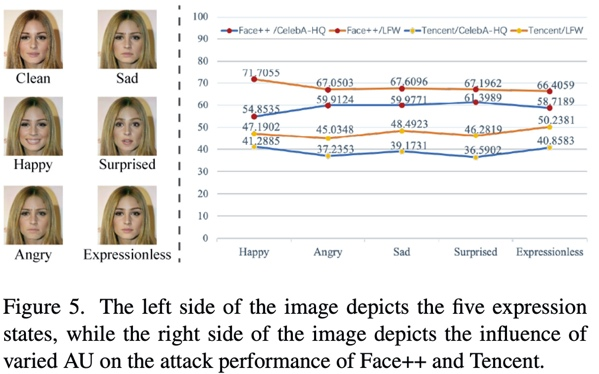

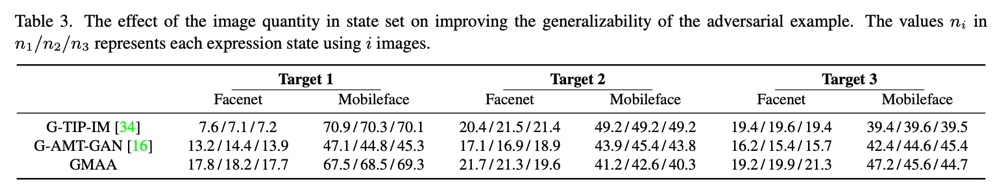

该研究还探讨了不同的表情对攻击性能的影响,以及状态集合中含有样本的数量对攻击泛化性能的影响。

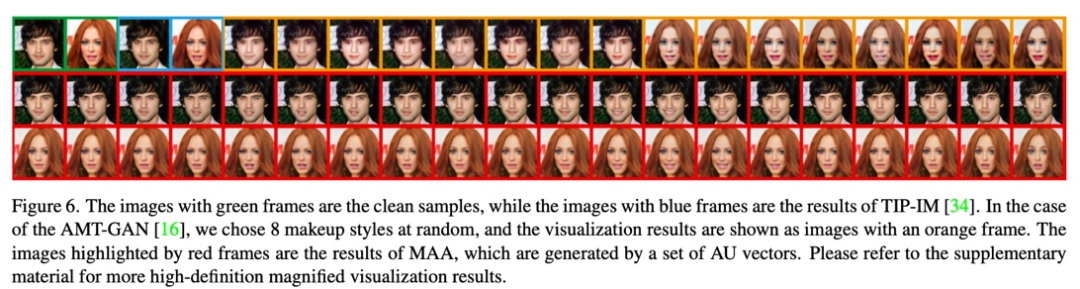

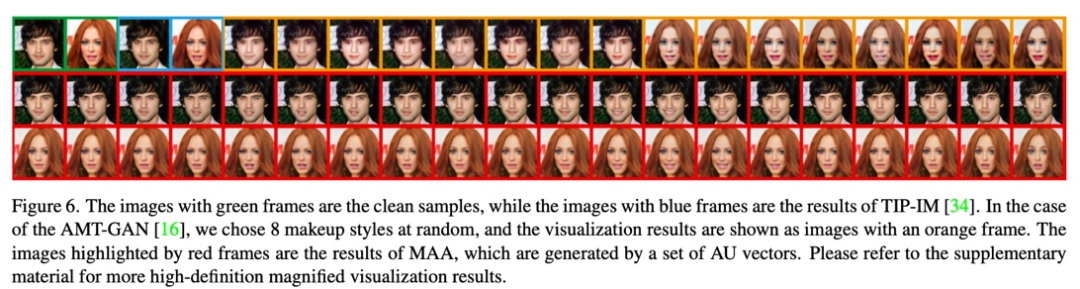

图 6 展示了不同方法的可视化结果对比,MAA 在对抗流形上采样了 20 个对抗样本,可以看到可视化效果更加的自然。

当然,并不是所有的数据集都有一个身份的不同状态的图片,对于这种情况怎么做目标域的扩充呢?该研究也给出了一个可行的解决方案,即用 AU 向量和表情编辑模型生成目标状态集合,文章也呈现了攻击合成的目标状态集合的结果,可以发现泛化性能也有一定提升。

原理方法

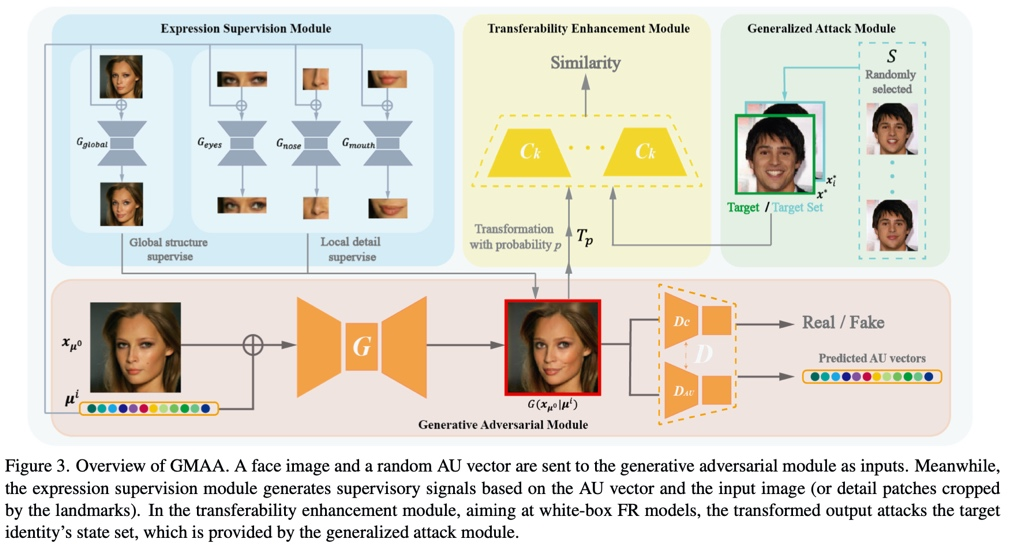

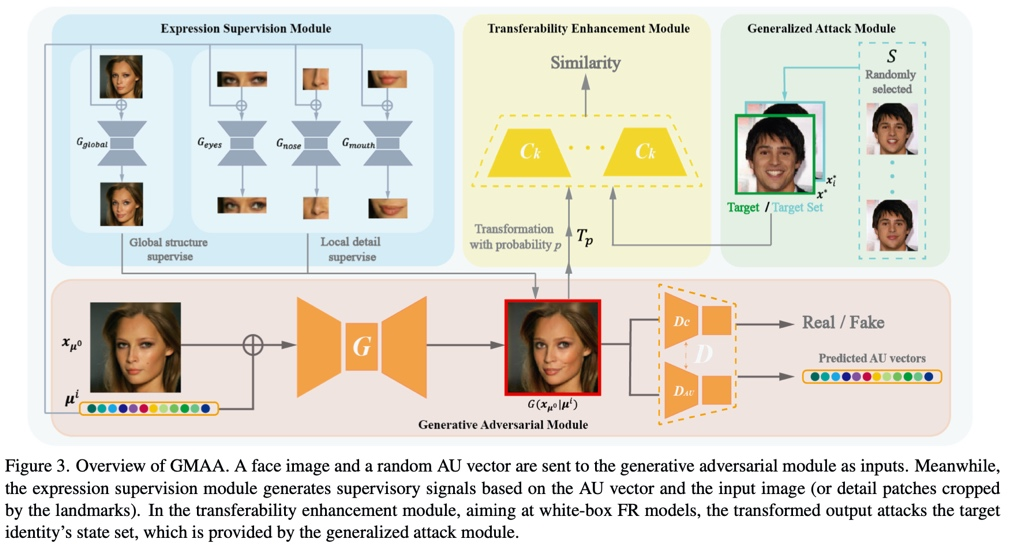

模型的主干包含了基于 WGAN-GP 的生成模块、表情监督模块、可转移性增强模块、广义攻击模块。其中,广义攻击模块实现了攻击目标状态集合的功能,可转移性增强模块来自于先前的工作,为了公平对比,所有的 baseline 都加上了这一模块。表情监督模块由 4 个训练好的表情编辑器构成,通过全局结构监督和局部细节监督来实现对抗样本的表情变换。

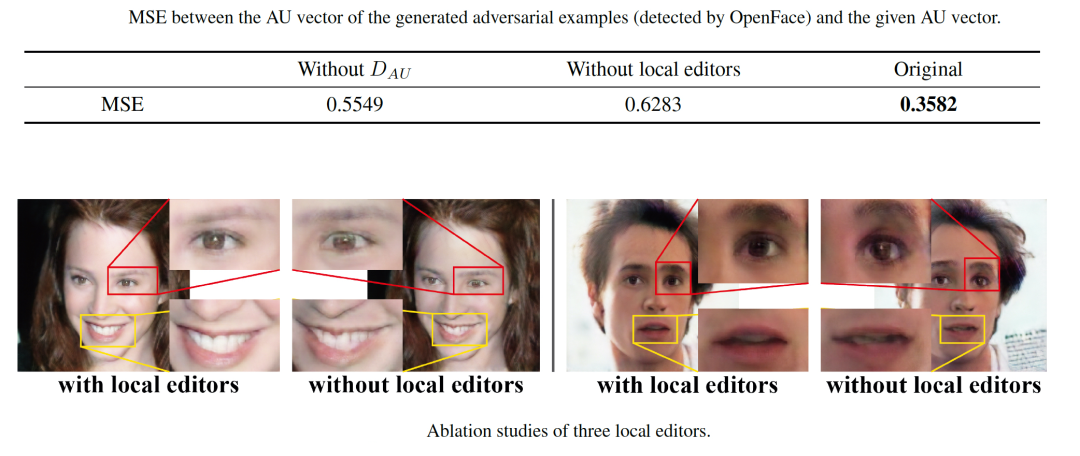

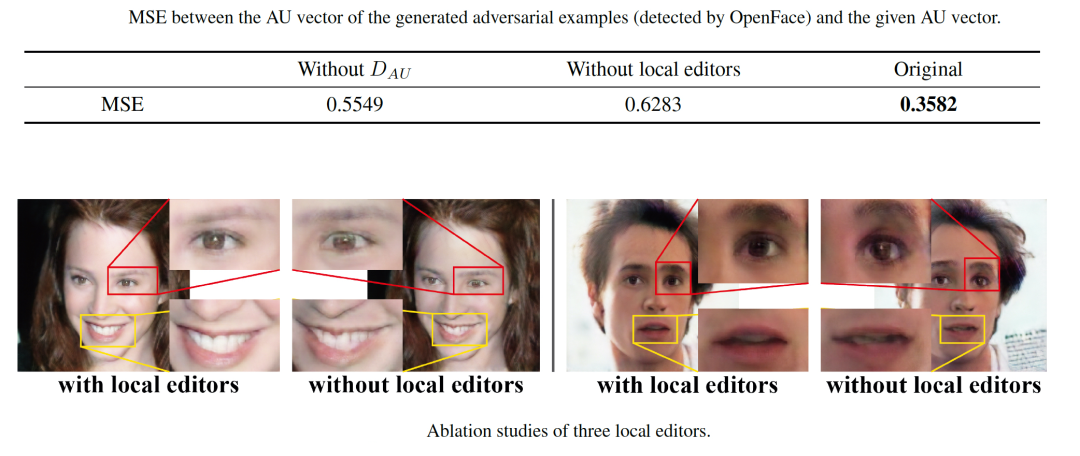

对于表情监督模块,论文的支持材料中给出了相应的消融实验,验证了局部细节监督可以减少生成图片的伪影和模糊,有效地提高对抗样本的视觉质量,同时可以提高对抗样本的表情合成准确性。

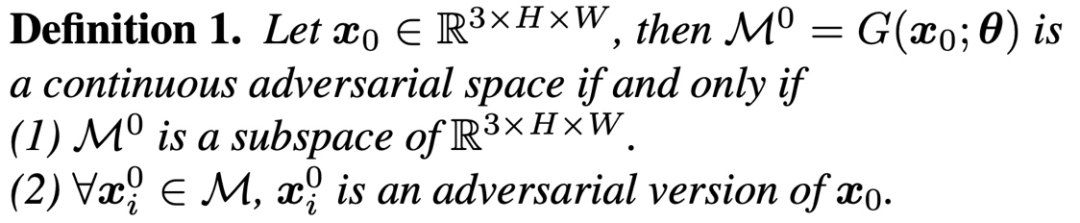

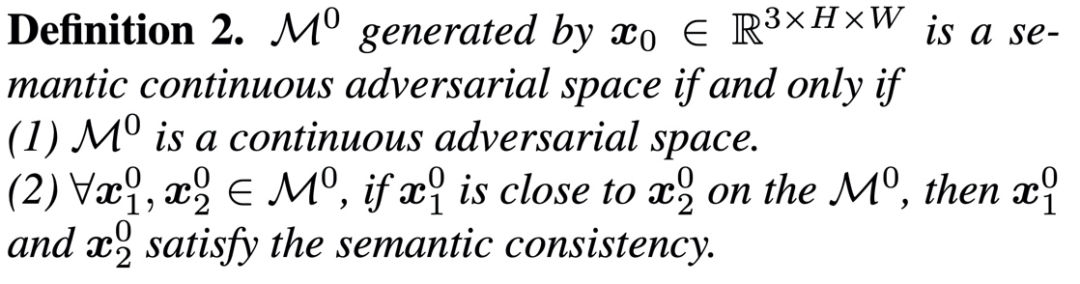

此外,论文定义了

连续对抗流形和语义连续对抗流形

的概念,并详细证明了

生成的对抗流形与 AU 向量空间同胚。

总结

综上所述,该研究提出了一种新的名为 GMAA 的攻击范式,同时

扩展了目标域和对抗域

,提高了攻击的性能。对于目标域,GMAA 通过攻击状态集合而不是单张图像来提升对目标身份的泛化能力。此外,

GMAA 将对抗域从离散点扩展到语义连续的对抗流形(“由点到面”)

。该研究通过引入表情编辑的领域知识实例化了 GMAA 攻击范式。大量的对比实验证明,GMAA 具有比其他竞争模型更好的攻击性能和更自然的视觉质量。