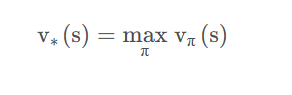

在开始证明之前,我想说的是

定理是证明给怀疑者,如果你对这个定理不怀疑,那么你就不需要证明

。接下来直观感受一下强化学习中值迭代的收敛性。

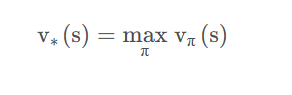

假设现在的

Agent

处于一个

state

s 下,想要去找一个

optimal state

,那怎么去找呢?就是遍历所有的

policy

能够使得当前的

state

s ,在遍历的某个

policy

π x下值最大,也就找到了这个

state

所对应的最大

value

,用数学语言描述如下:

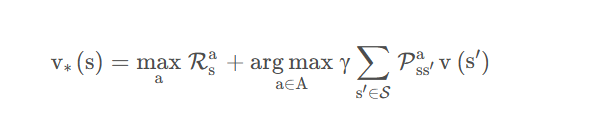

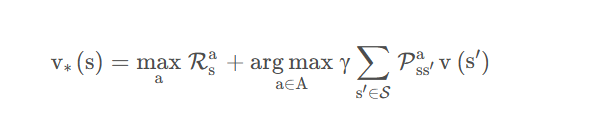

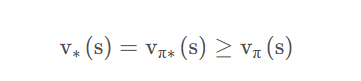

不用去怀疑,你一定能找到这样的一个最大的

state value

,因为你遍历了所有的

policy

。那能够使得

state value

最大的那个

policy

π x

就是

optimal policy

π ∗

,即

π x = π ∗

。那此时贝尔曼方程就是一个完全收敛的情况,可表示为:

如果不收敛,那它(

value

)肯定还没有到达

optimal variable

。上述等式在收敛的情况下就会成立,而不仅仅是一个赋值的关系。

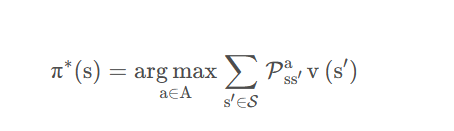

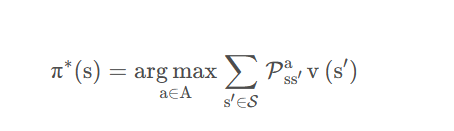

观察上述式子,

optimal policy

是什么?也即每次是如何

take action

的呢?也就是等式的右端项:

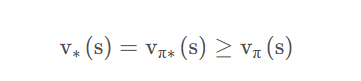

那随便给一个状态,我们每次都按照

optimal policy

去

take action

,那每次

state value

都会大于等于之前非最优的

policy

所得出来的

state value

吧:

也就是说每次都按照

optimal policy

去

take action

,

state value

其实都会有所改进(或者至少不会比以前的差)。那真实的

state value

总有一个上界吧,总会收敛吧。

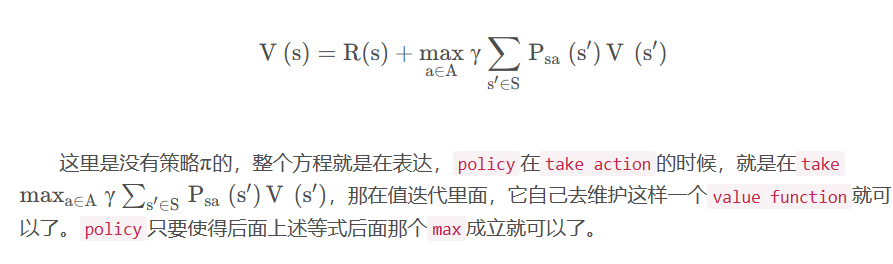

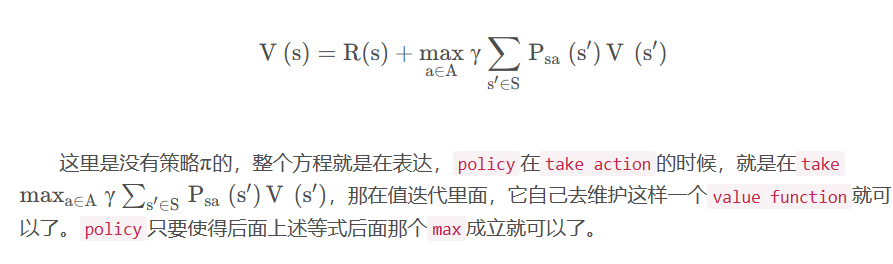

再来看看值迭代

value iteration

,其实就是不断地去套

bellman equation

,就变成了对于每一个

state

去计算V ( s ) 。

我的

微信公众号名称

:深度学习先进智能决策

微信公众号ID

:tinyzqh

公众号介绍

:主要研究深度学习、强化学习、机器博弈等相关内容!期待您的关注,欢迎一起学习交流进步!