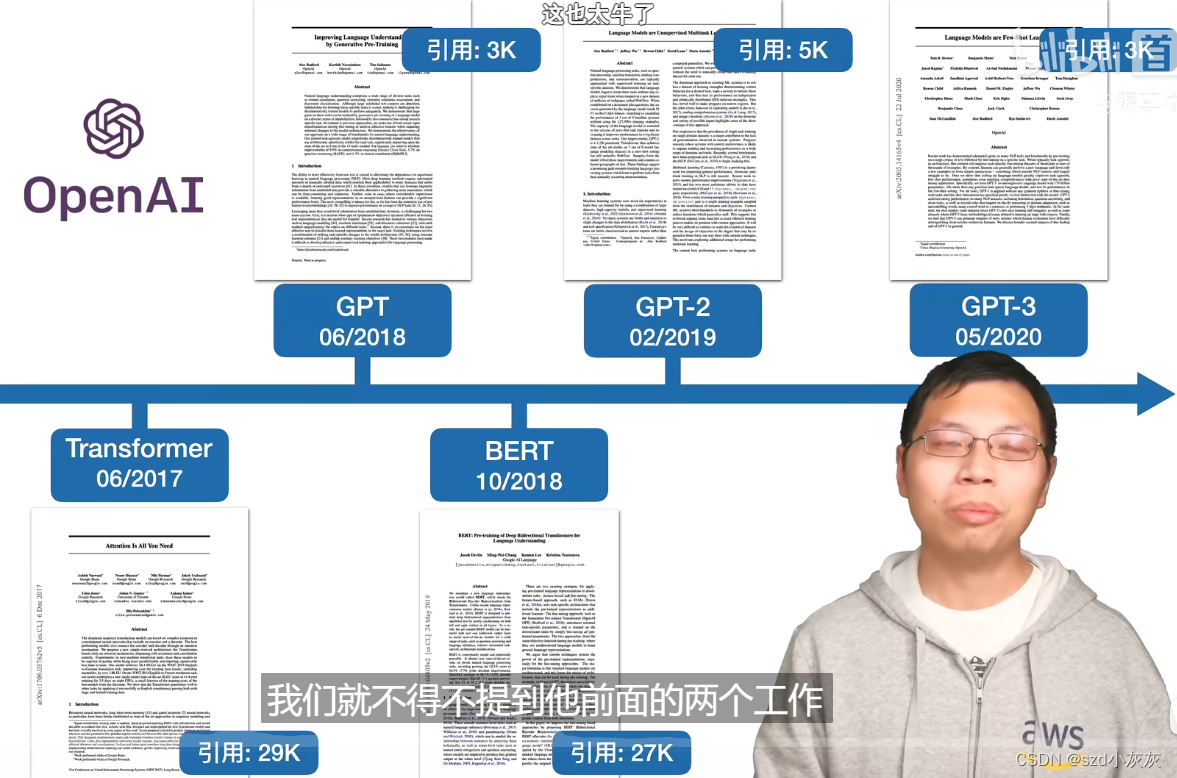

transformer

link之家

链接快照平台

- 输入网页链接,自动生成快照

- 标签化管理网页链接

相关文章推荐

|

|

力能扛鼎的夕阳 · 基于YOLOv8/YOLOv7/YOLOv6 ...· 3 周前 · |

|

|

聪明的海龟 · (数据科学学习手札42)folium进阶内容 ...· 1 月前 · |

|

|

腼腆的小熊猫 · sonatype ...· 4 月前 · |

|

|

斯文的春卷 · Mongodb ...· 1 年前 · |

|

|

睿智的跑步鞋 · Getting error while ...· 1 年前 · |

百度飞桨AI Studio社区

aistudio.csdn.net

百度飞桨AI Studio社区

aistudio.csdn.net

松山湖开发者村综合服务平台

songshanhu.csdn.net

松山湖开发者村综合服务平台

songshanhu.csdn.net

科技大事业开发者社区

devpress.csdn.net/developer

科技大事业开发者社区

devpress.csdn.net/developer

华为云开发者联盟

huaweicloud.csdn.net

华为云开发者联盟

huaweicloud.csdn.net

开源项目管理

devpress.csdn.net/gitcode

开源项目管理

devpress.csdn.net/gitcode

智慧地球 AI·Earth

devpress.csdn.net/aiearth

智慧地球 AI·Earth

devpress.csdn.net/aiearth

ModelScope魔搭社区

community.modelscope.cn

ModelScope魔搭社区

community.modelscope.cn